parent

5ba9c2ee53

commit

334a85fd1c

@ -0,0 +1,134 @@ |

|||||||

|

# iOS下的渲染框架 |

||||||

|

|

||||||

|

## 1.图形渲染框架 |

||||||

|

|

||||||

|

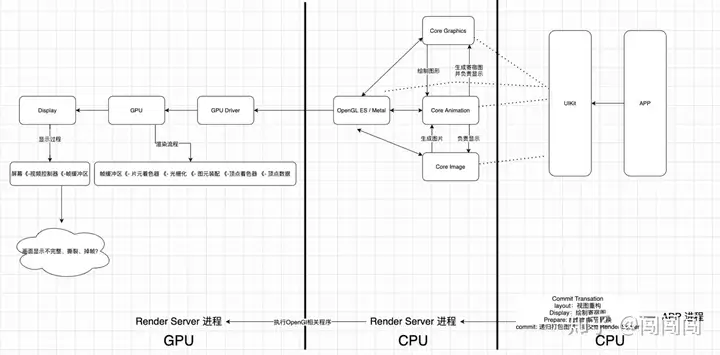

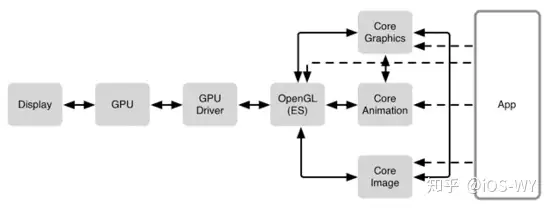

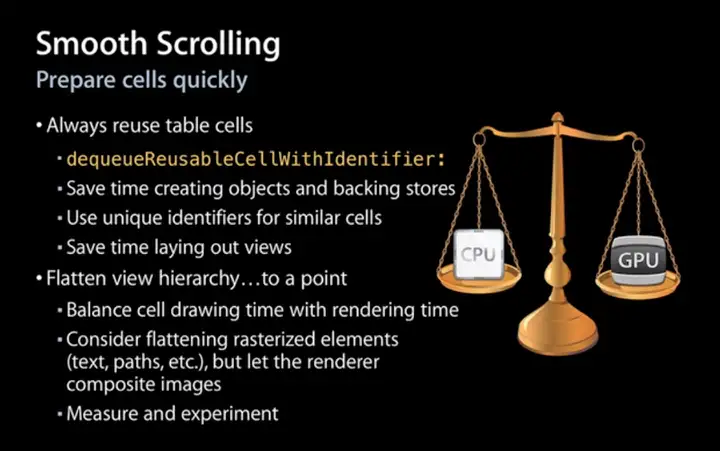

iOS APP图形渲染框架,APP在显示可视化的图形时,使用到了Core Animation、Core Graphics、Core Image等框架,这些框架在渲染图形时,都需要通过OpenGL ES / Metal来驱动GPU进行渲染与绘制。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- **UIKit** |

||||||

|

|

||||||

|

UIKit是iOS开发最常用的框架,可以通过设置UIKit组件的布局以及相关属性来绘制界面。 |

||||||

|

事实上,UIKit自身并不具备在屏幕成像的能力,其主要负责对用户操作事件的响应(UIView继承自UIResponder),事件响应的传递大体是经过逐层的**视图树**遍历实现的。 |

||||||

|

|

||||||

|

- **Core Animation** |

||||||

|

|

||||||

|

Core Animation源自于Layer Kit,动画只是Core Animation的冰山一角。 |

||||||

|

Core Animation是一个复合引擎,其职责是**尽可能快地组合屏幕上不同的可视内容,这些可视内容可被分解成独立的图层(即CALayer),这些图层会被存储在一个叫做图层树的体系之中**。从本质上而言,CALayer是用户所能在屏幕上看见的一切的基础。 |

||||||

|

|

||||||

|

- **Core Graphics** |

||||||

|

|

||||||

|

Core Graphics是基于Quartz 的高级绘图引擎,主要用于运行时绘制图像。开发者可以使用此框架来处理基于路径的绘图,转换,颜色管理,离屏渲染,图案,渐变和阴影,图像数据管理,图像创建和图像遮罩以及PDF文档创建,显示和分析。 |

||||||

|

|

||||||

|

- **Core Image** |

||||||

|

|

||||||

|

Core Image与Core Graphics恰恰相反,Core Graphics用于在运行时创建图像,而Core Image用于处理运行前创建的图像。Core Image框架拥有一系列现成的图像过滤器,能对一寸照的图像进行高效的处理。大部分情况下,Core Image会在GPU中完成工作,如果GPU忙,会使用CPU进行处理。 |

||||||

|

|

||||||

|

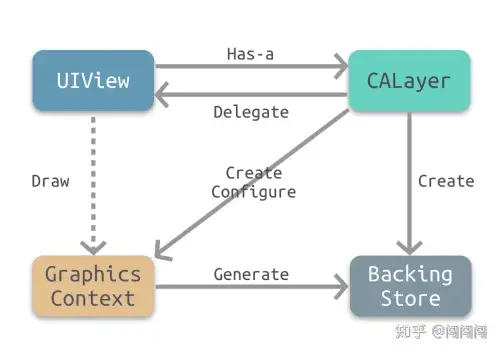

## 2.UIView与CALayer的关系 |

||||||

|

|

||||||

|

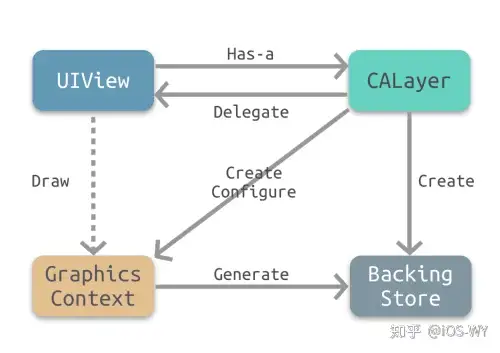

CALayer事实上是用户所能在屏幕上看见的一切的基础。为什么UIKit中的视图能够呈现可视化内容,就是因为UIKit中的每一个UI视图控件其实内部都有一个关联的CALayer,即backing layer。 |

||||||

|

|

||||||

|

由于这种一一对应的关系,视图层级有用**视图树**的树形结构,对应CALayer层级也拥有**图层树**的树形结构。 |

||||||

|

|

||||||

|

其中,视图的职责是创建并管理图层,以确保当子视图在层级关系中添加或被移除时,其关联的图层在图层树中也有相同的操作,即保证视图树和图层树在结构上的一致性。 |

||||||

|

|

||||||

|

为什么iOS要基于UIView和CALayer提供两个平行的层级关系呢? |

||||||

|

|

||||||

|

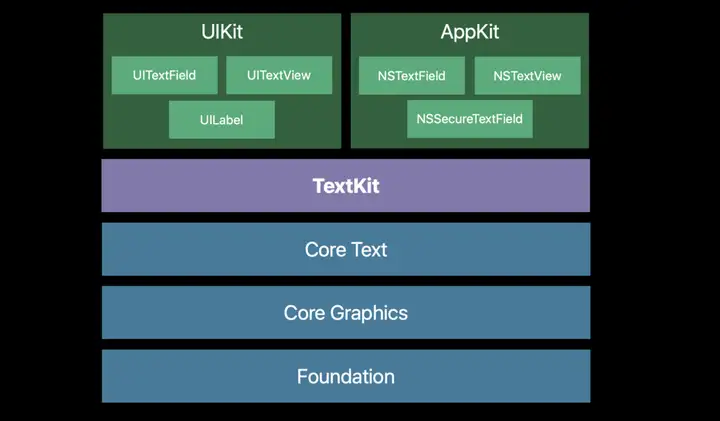

其原因在于要做**职责分离**,这样也能避免很多重复代码。在iOS和Mac OSX两个平台上,事件和用户交互有很多地方的不同,基于多点触控的用户界面和基于鼠标键盘的交互有着本质的区别,这就是为什么iOS有UIKit和UIView,对应Mac OSX有AppKit和NSView的原因。它们在功能上很相似,但是在实现上有着显著的区别。实际上,这里并不是两个层级关系,而是四个。每一个都扮演着不同的角色。除了**视图树**和**图层树**,还有**呈现树**和**渲染树**。 |

||||||

|

|

||||||

|

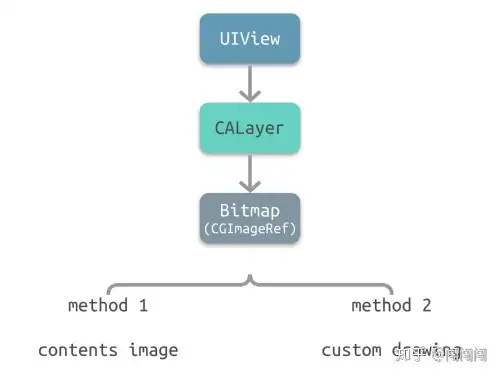

那么为什么CALayer可以呈现可视化内容呢?因为CALayer基本等同于一个**纹理**。纹理是GPU进行图像渲染的重要依据。 |

||||||

|

|

||||||

|

在[图形渲染原理](https://link.zhihu.com/?target=https%3A//links.jianshu.com/go%3Fto%3Dhttp%3A%2F%2Fchuquan.me%2F2018%2F08%2F26%2Fgraphics-rending-principle-gpu%2F)中提到纹理本质上就是一张图片,因此CALayer也包含一个contents属性指向一块缓存区,称为backing store,可以存放位图(Bitmap)。iOS中将该缓存区保存的图片称为**寄宿图**。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

图形渲染流水线支持从顶点开始进行绘制(在流水线中,顶点会被处理生成纹理),也支持直接使用纹理(图片)进行渲染。相应地,在实际开发中,绘制界面也有两种方式: 一种是**手动绘制**;另一种是**使用图片**。 |

||||||

|

|

||||||

|

对此,iOS中也有两种相应的实现方式: |

||||||

|

|

||||||

|

- 使用图片:contents image |

||||||

|

- 手动绘制:custom drawing |

||||||

|

|

||||||

|

**Contents Image** |

||||||

|

Contents Image是指通过CALayer的contents属性来配置图片。然而,contents属性的类型为id,在这种情况下,可以给contents属性赋予任何值,app仍可以编译通过。但是在实践中,如果contents的值不是CGImage,得到的图层将是空白的。 |

||||||

|

既然如此,为什么要将contents的属性类型定义为id而非CGImage。因为在Mac OS系统中,该属性对CGImage和NSImage类型的值都起作用,而在iOS系统中,该属性只对CGImage起作用。 |

||||||

|

本质上,contents属性指向的一块缓存区域,称为backing store,可以存放bitmap数据。 |

||||||

|

**Custom Drawing** |

||||||

|

Custom Drawing是指使用Core Graphics直接绘制寄宿图。实际开发中,一般通过继承UIView并实现-drawRect:方法来自定义绘制。 |

||||||

|

虽然-drawRect:是一个UIView方法,但事实上都是底层的CALayer完成了重绘工作并保存了产生的图片。 |

||||||

|

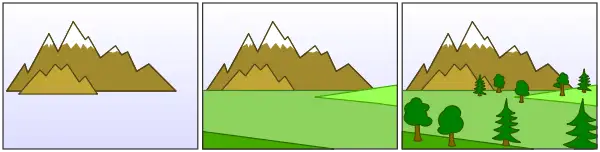

下图所示为drawRect:绘制定义寄宿图的基本原理 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- UIView有一个关联图层,即CALayer。 |

||||||

|

- CALayer有一个可选的delegate属性,实现了CALayerDelegate协议。UIView作为CALayer的代理实现了CALayerDelegate协议。 |

||||||

|

- 当需要重绘时,即调用-drawRect:,CALayer请求其代理给予一个寄宿图来显示。 |

||||||

|

- CALayer首先会尝试调用-displayLayer:方法,此时代理可以直接设置contents属性。 |

||||||

|

|

||||||

|

```objective-c |

||||||

|

- (void)displayLayer:(CALayer *)layer; |

||||||

|

``` |

||||||

|

|

||||||

|

- 如果代理没有实现-displayLayer:方法,CALayer则会尝试调用`-`drawLayer:inContext:方法。在调用该方法前,CALayer会创建一个空的寄宿图(尺寸由bounds和contentScale决定)和一个Core Graphics的绘制上下文,为绘制寄宿图做准备,作为ctx参数传入。 |

||||||

|

|

||||||

|

```objective-c |

||||||

|

- (void)drawLayer:(CALayer *)layer inContext:(CGContextRef)ctx; |

||||||

|

``` |

||||||

|

|

||||||

|

- 最后,有Core Graphics绘制生成的寄宿图会存入backing store。 |

||||||

|

|

||||||

|

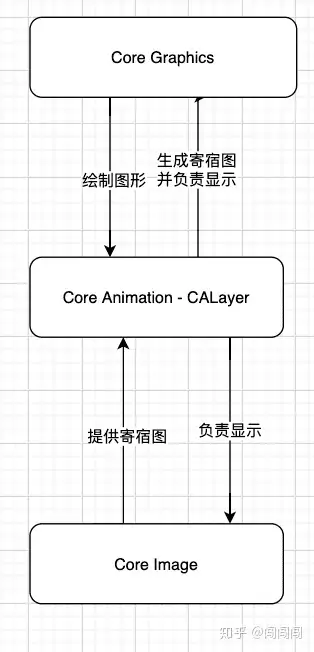

**三个框架间的依赖关系** |

||||||

|

|

||||||

|

Core Animation、Core Graphics、Core Image这个三个框架间也存在着依赖关系。 |

||||||

|

|

||||||

|

上面提到CALayer是用户所能在屏幕上看到一切的基础。所以Core Graphics、Core Image是需要依赖于CALayer来显示界面的。由于CALayer又是Core Animation框架提供的,所以说Core Graphics、Core Image是依赖于``Core Animation ```的。 |

||||||

|

|

||||||

|

上文还提到每一个 UIView 内部都关联一个CALayer图层,即backing layer,每一个CALayer都包含一个content属性指向一块缓存区,即backing store, 里面存放位图(Bitmap)。iOS中将该缓存区保存的图片称为寄宿图。 |

||||||

|

|

||||||

|

这个寄宿图有两个设置方式: |

||||||

|

|

||||||

|

直接向content设置CGImage图片,这需要依赖Core Image来提供图片。 |

||||||

|

|

||||||

|

通过实现UIView的drawRect方法自定义绘图,这需要借助Core Graphics来绘制图形,再由CALayer生成图片。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 3.Core Animation 流水线 |

||||||

|

|

||||||

|

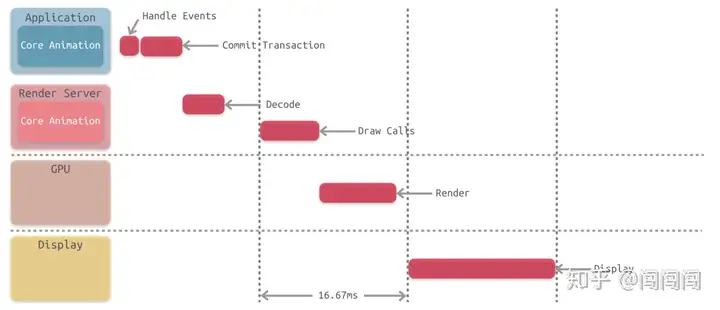

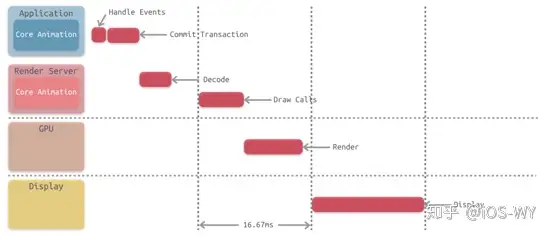

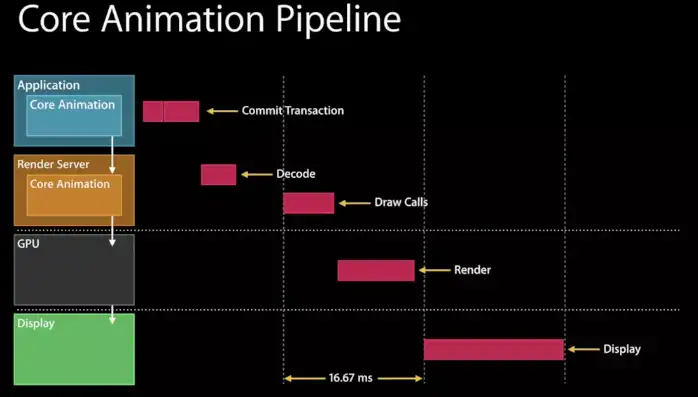

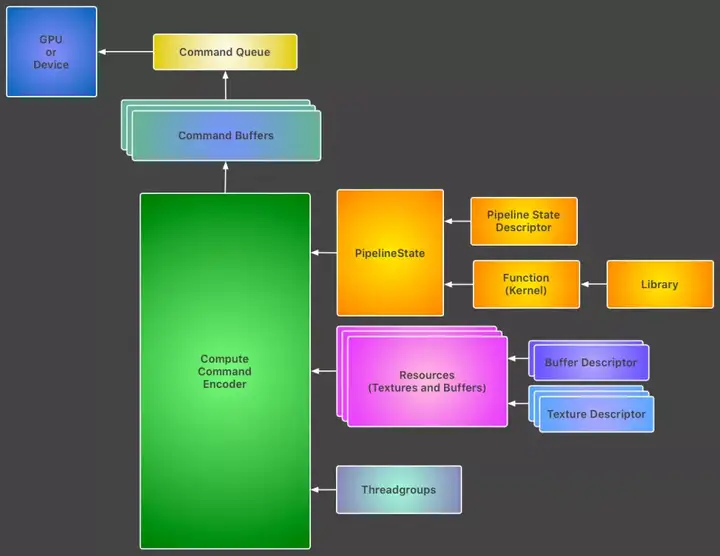

CALayer是如何调用 GPU 并显示可视化内容的呢?下面我们就需要介绍一下 Core Animation 流水线的工作原理。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

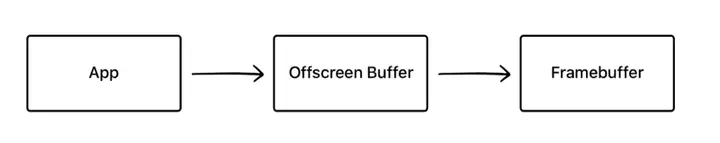

事实上,app 本身并不负责渲染,渲染则是由一个独立的进程负责,即Render Server进程。 |

||||||

|

|

||||||

|

App 通过 IPC 将渲染任务及相关数据提交给Render Server。Render Server处理完数据后,再传递至 GPU。最后由 GPU 调用 iOS 的图像设备进行显示。 |

||||||

|

|

||||||

|

Core Animation 流水线的详细过程如下: |

||||||

|

|

||||||

|

首先,由 app 处理事件(Handle Events),如:用户的点击操作,在此过程中 app 可能需要更新**视图树**,相应地,**图层树**也会被更新。 |

||||||

|

|

||||||

|

其次,app 通过 CPU 完成对显示内容的计算,如:视图的创建、布局计算、图片解码、文本绘制等。在完成对显示内容的计算之后,app 对图层进行打包,并在下一次 RunLoop 时将其发送至Render Server,即完成了一次Commit Transaction操作。 |

||||||

|

|

||||||

|

Render Server主要执行 Open GL、Core Graphics 相关程序,并调用 GPU |

||||||

|

|

||||||

|

GPU 则在物理层上完成了对图像的渲染。 |

||||||

|

|

||||||

|

最终,GPU 通过 Frame Buffer、视频控制器等相关部件,将图像显示在屏幕上。 |

||||||

|

|

||||||

|

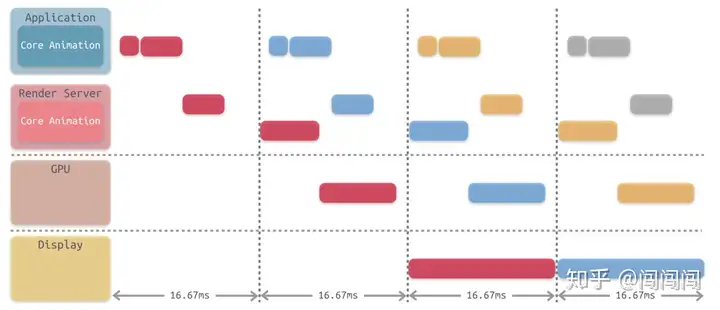

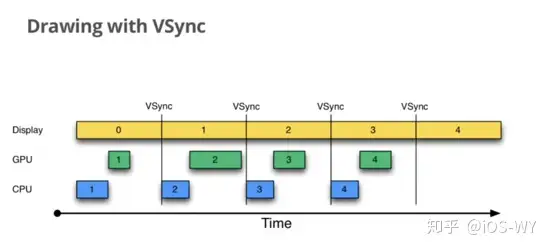

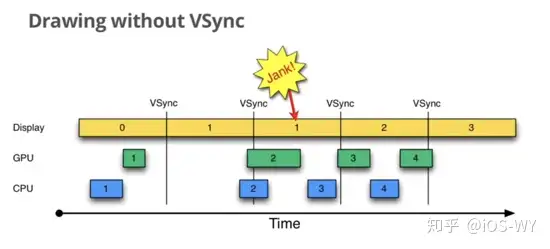

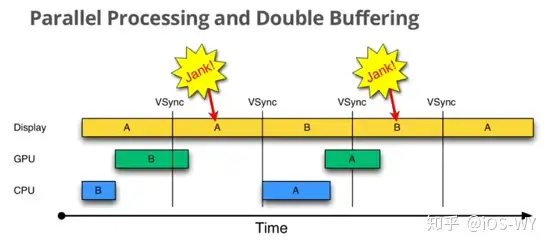

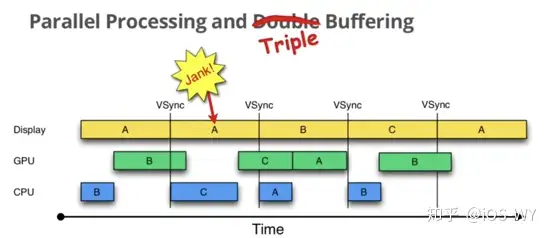

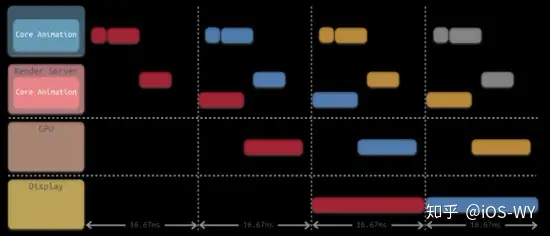

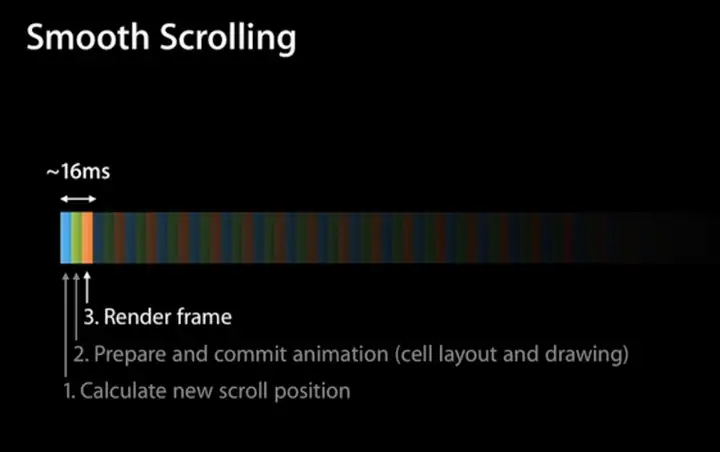

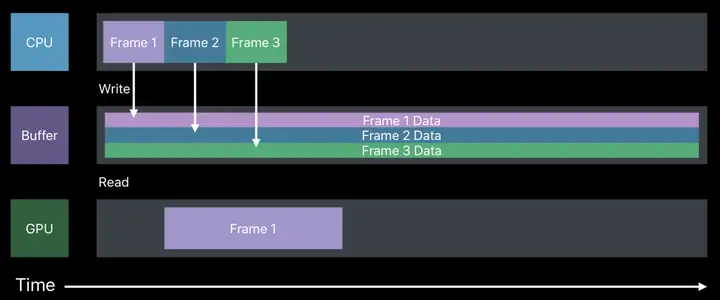

对上述步骤进行串联,它们执行所消耗的时间远远超过 16.67 ms,因此为了满足对屏幕的 60 FPS 刷新率的支持,需要将这些步骤进行分解,通过流水线的方式进行并行执行,如下图所示。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

**Commit Transaction** |

||||||

|

|

||||||

|

在 Core Animation 流水线中,app 调用Render Server前的最后一步 Commit Transaction 其实可以细分为 4 个步骤: |

||||||

|

|

||||||

|

Layout:主要进行视图构建,包括:LayoutSubviews方法的重载,addSubview:方法填充子视图等。 |

||||||

|

|

||||||

|

Display:视图绘制,这里仅仅是绘制寄宿图,该过程使用CPU和内存 |

||||||

|

|

||||||

|

Prepare:阶段属于附加步骤,一般处理图像的解码和转换等操作 |

||||||

|

|

||||||

|

Commit:主要将图层进行打包,并将它们发送至 Render Server。该过程会递归执行,因为图层和视图都是以树形结构存在。 |

||||||

|

|

||||||

|

原文https://zhuanlan.zhihu.com/p/157556221 |

||||||

@ -0,0 +1,367 @@ |

|||||||

|

# iOS音视频 -- AVFoundation捕捉 |

||||||

|

|

||||||

|

## 1、视频捕捉 |

||||||

|

|

||||||

|

### **1.1、实现QuickTime视频的录制** |

||||||

|

|

||||||

|

在上文中,简述了通过AVCapturePhotoOutput、AVCapturePhotoSettings来实现代理,获取当前摄像头所捕捉到的photo数据,生成一张图片。 |

||||||

|

|

||||||

|

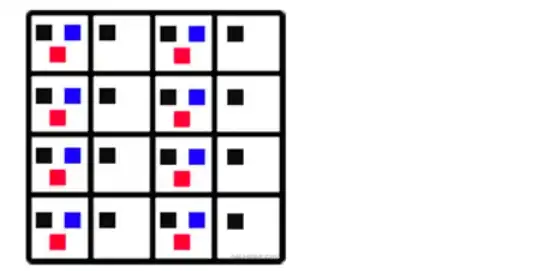

视频录制过程大致也是如此,通过AVCaptureMovieFileOutput来获取视频数据,大致流程如下: |

||||||

|

|

||||||

|

\1. 开启录制之前需要判断当前是否处于录制状态,只有在非录制状态才能进入录制状态 |

||||||

|

|

||||||

|

```text |

||||||

|

/// 是否在录制状态 |

||||||

|

- (BOOL)isRecording { |

||||||

|

return self.movieOutput.isRecording; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\2. 通过AVCaptureConnection来获取当前视频捕捉的连接信息 |

||||||

|

|

||||||

|

\1. 调整视频方向 |

||||||

|

|

||||||

|

\2. 判断是否支持视频稳定功能(非必要) |

||||||

|

|

||||||

|

\3. 判读是否支持平滑对焦(非必要) |

||||||

|

|

||||||

|

\4. 为视频输出配置输出路径 |

||||||

|

|

||||||

|

\5. 开始视频recording |

||||||

|

|

||||||

|

```text |

||||||

|

/// 开始录制 |

||||||

|

- (void)startRecording { |

||||||

|

|

||||||

|

if (![self isRecording]) { |

||||||

|

//获取当前视频捕捉连接信息 |

||||||

|

AVCaptureConnection *videoConnection = [self.movieOutput connectionWithMediaType:AVMediaTypeVideo]; |

||||||

|

|

||||||

|

//调整方向 |

||||||

|

if ([videoConnection isVideoOrientationSupported]) { |

||||||

|

videoConnection.videoOrientation = [self currentVideoOrientation]; |

||||||

|

} |

||||||

|

|

||||||

|

//判断是否支持视频稳定功能(保证视频质量) |

||||||

|

if ([videoConnection isVideoStabilizationSupported]) { |

||||||

|

videoConnection.preferredVideoStabilizationMode = YES; |

||||||

|

} |

||||||

|

|

||||||

|

//拿到活跃的摄像头 |

||||||

|

AVCaptureDevice *device = [self activeCamera]; |

||||||

|

//判断是否支持平滑对焦(当用户移动设备时, 能自动且快速的对焦) |

||||||

|

if (device.isSmoothAutoFocusEnabled) { |

||||||

|

NSError *error; |

||||||

|

if ([device lockForConfiguration:&error]) { |

||||||

|

device.smoothAutoFocusEnabled = YES; |

||||||

|

[device unlockForConfiguration]; |

||||||

|

} else { |

||||||

|

//失败回调 |

||||||

|

|

||||||

|

} |

||||||

|

} |

||||||

|

|

||||||

|

//获取路径 |

||||||

|

self.outputURL = [self uniqueURL]; |

||||||

|

|

||||||

|

//摄像头的相关配置完成, 也获取到路径, 开始录制(这里录制QuckTime视频文件, 保存到相册) |

||||||

|

[self.movieOutput startRecordingToOutputFileURL:self.outputURL recordingDelegate:self]; |

||||||

|

|

||||||

|

} |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\3. 停止视频recording |

||||||

|

|

||||||

|

```text |

||||||

|

/// 停止录制 |

||||||

|

- (void)stopRecording { |

||||||

|

if ([self isRecording]) { |

||||||

|

[self.movieOutput stopRecording]; |

||||||

|

} |

||||||

|

} |

||||||

|

///路径转换 |

||||||

|

- (NSURL *)uniqueURL { |

||||||

|

NSURL *url = [NSURL fileURLWithPath:[NSString stringWithFormat:@"%@%@", NSTemporaryDirectory(), @"output.mov"]]; |

||||||

|

return url; |

||||||

|

} |

||||||

|

///获取方向值 |

||||||

|

- (AVCaptureVideoOrientation)currentVideoOrientation { |

||||||

|

AVCaptureVideoOrientation result; |

||||||

|

|

||||||

|

UIDeviceOrientation deviceOrientation = [UIDevice currentDevice].orientation; |

||||||

|

switch (deviceOrientation) { |

||||||

|

case UIDeviceOrientationPortrait: |

||||||

|

case UIDeviceOrientationFaceUp: |

||||||

|

case UIDeviceOrientationFaceDown: |

||||||

|

result = AVCaptureVideoOrientationPortrait; |

||||||

|

break; |

||||||

|

case UIDeviceOrientationPortraitUpsideDown: |

||||||

|

//如果这里设置成AVCaptureVideoOrientationPortraitUpsideDown,则视频方向和拍摄时的方向是相反的。 |

||||||

|

result = AVCaptureVideoOrientationPortrait; |

||||||

|

break; |

||||||

|

case UIDeviceOrientationLandscapeLeft: |

||||||

|

result = AVCaptureVideoOrientationLandscapeRight; |

||||||

|

break; |

||||||

|

case UIDeviceOrientationLandscapeRight: |

||||||

|

result = AVCaptureVideoOrientationLandscapeLeft; |

||||||

|

break; |

||||||

|

default: |

||||||

|

result = AVCaptureVideoOrientationPortrait; |

||||||

|

break; |

||||||

|

} |

||||||

|

return result; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\4. 保存影片至相册 |

||||||

|

|

||||||

|

```text |

||||||

|

///通过代理来获取视频数据#pragma mark - AVCaptureFileOutputRecordingDelegate |

||||||

|

- (void)captureOutput:(AVCaptureFileOutput *)captureOutput |

||||||

|

didFinishRecordingToOutputFileAtURL:(NSURL *)outputFileURL |

||||||

|

fromConnections:(NSArray *)connections |

||||||

|

error:(NSError *)error { |

||||||

|

if (error) { |

||||||

|

//错误回调 |

||||||

|

|

||||||

|

} else { |

||||||

|

//视频写入到相册 |

||||||

|

[self writeVideoToAssetsLibrary:[self.outputURL copy]]; |

||||||

|

} |

||||||

|

self.outputURL = nil; |

||||||

|

} |

||||||

|

//写入捕捉到的视频 |

||||||

|

- (void)writeVideoToAssetsLibrary:(NSURL *)videoURL { |

||||||

|

|

||||||

|

__block PHObjectPlaceholder *assetPlaceholder = nil; |

||||||

|

[[PHPhotoLibrary sharedPhotoLibrary] performChanges:^{ |

||||||

|

//保存进相册 |

||||||

|

PHAssetChangeRequest *changeRequest = [PHAssetChangeRequest creationRequestForAssetFromVideoAtFileURL:videoURL]; |

||||||

|

assetPlaceholder = changeRequest.placeholderForCreatedAsset; |

||||||

|

|

||||||

|

} completionHandler:^(BOOL success, NSError * _Nullable error) { |

||||||

|

NSLog(@"OK"); |

||||||

|

//保存成功 |

||||||

|

dispatch_async(dispatch_get_main_queue(), ^{ |

||||||

|

|

||||||

|

//通知外部一个略缩图 |

||||||

|

[self generateThumbnailForVideoAtURL:videoURL]; |

||||||

|

|

||||||

|

}); |

||||||

|

|

||||||

|

}]; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\5. 生成一个略缩图通知外部 |

||||||

|

|

||||||

|

```text |

||||||

|

///通过视频获取视频的第一帧图片当做略缩图 |

||||||

|

- (void)generateThumbnailForVideoAtURL:(NSURL *)videoURL { |

||||||

|

|

||||||

|

dispatch_async(self.videoQueue, ^{ |

||||||

|

|

||||||

|

//拿到视频信息 |

||||||

|

AVAsset *asset = [AVAsset assetWithURL:videoURL]; |

||||||

|

AVAssetImageGenerator *imageGenerator = [AVAssetImageGenerator assetImageGeneratorWithAsset:asset]; |

||||||

|

imageGenerator.maximumSize = CGSizeMake(100, 0); |

||||||

|

imageGenerator.appliesPreferredTrackTransform = YES; |

||||||

|

|

||||||

|

//通过视频将第一帧图片数据转化为CGImage |

||||||

|

CGImageRef imageRef = [imageGenerator copyCGImageAtTime:kCMTimeZero actualTime:NULL error:nil]; |

||||||

|

UIImage *image = [UIImage imageWithCGImage:imageRef]; |

||||||

|

|

||||||

|

//通知外部 |

||||||

|

NSNotificationCenter *nc = [NSNotificationCenter defaultCenter]; |

||||||

|

[nc postNotificationName:ThumbnailCreatedNotification object:image]; |

||||||

|

|

||||||

|

}); |

||||||

|

|

||||||

|

|

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

### **1.2、关于QuickTime** |

||||||

|

|

||||||

|

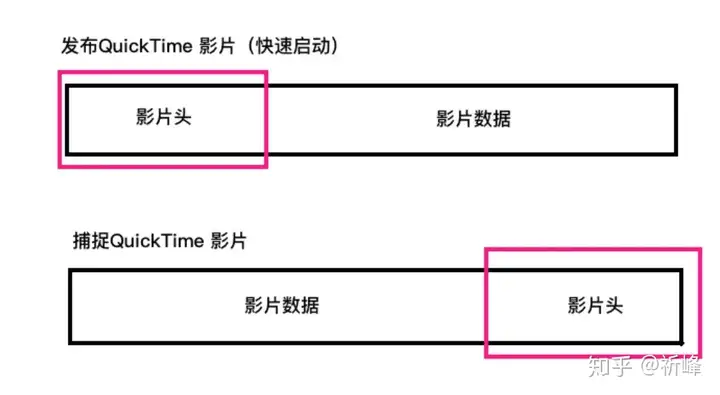

上文主要是通过AVCaptureMovieFileOutput将QuickTime影片捕捉到磁盘,这个类大多数核心功能继承与超类AVCaptureFileOutput。它有很多实用的功能,例如:录制到最长时限或录制到特定文件大小为止。 |

||||||

|

|

||||||

|

通常当QuickTime影片准备发布时,影片头的元数据处于文件的开始位置。这样可以让视频播放器快速读取头包含信息,来确定文件的内容、结构和其包含的多个样本的位置。当录制一个QuickTime影片时,直到所有的样片都完成捕捉后才能创建信息头。当录制结束时,创建头数据并将它附在文件结尾。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

将创建头的过程放在所有影片样本完成捕捉之后存在一个问题。 在移动设备中,比如录制的时候接到电话或者程序崩溃等问题,影片头就不能被正确写入。会在磁盘生成一个不可读的影片文件。AVCaptureMovieFileOutput提供一个核心功能就是分段捕捉QuickTime影片。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 2、AVFoundation的人脸识别 |

||||||

|

|

||||||

|

人脸识别实际上是非常复杂的一个功能,要想自己完全实现人脸识别是非常困难的。苹果为我们做了很多人脸识别的功能,例如CoreImage、AVFoundation,都是有人脸识别的功能的。还有Vision face++ 等。这里就简单介绍一下AVFoundation中的人脸识别。 |

||||||

|

|

||||||

|

在拍摄视频中,我们通过AVFoundation的人脸识别,在屏幕界面上用一个红色矩形来标识识别到的人脸。 |

||||||

|

|

||||||

|

### **2.1、人脸识别流程** |

||||||

|

|

||||||

|

\1. 使用AVCaptureMetadataOutput来建立输出 |

||||||

|

|

||||||

|

\1. 添加进session |

||||||

|

|

||||||

|

\2. 设置获取数据类型 |

||||||

|

|

||||||

|

\3. 在主线程中执行任务 |

||||||

|

|

||||||

|

```text |

||||||

|

- (BOOL)setupSessionOutputs:(NSError **)error { |

||||||

|

//配置输入信息 |

||||||

|

self.metadataOutput = [[AVCaptureMetadataOutput alloc] init]; |

||||||

|

//对session添加输出 |

||||||

|

if ([self.captureSession canAddOutput:self.metadataOutput]) { |

||||||

|

[self.captureSession addOutput:self.metadataOutput]; |

||||||

|

//从输出数据中设置只获取人脸数据(可以是人脸、二维码、一维码....) |

||||||

|

NSArray *metadataObjectType = @[AVMetadataObjectTypeFace]; |

||||||

|

self.metadataOutput.metadataObjectTypes = metadataObjectType; |

||||||

|

|

||||||

|

//因为人脸检测使用了硬件加速器GPU, 所以它的任务需要在主线程中执行 |

||||||

|

dispatch_queue_t mainQueue = dispatch_get_main_queue(); |

||||||

|

//设置metadataOutput代理方法, 检测视频中一帧一帧数据里是否包含人脸数据. 如果包含则调用回调方法 |

||||||

|

[self.metadataOutput setMetadataObjectsDelegate:self queue:mainQueue]; |

||||||

|

return YES; |

||||||

|

} else { |

||||||

|

//错误回调 |

||||||

|

} |

||||||

|

return NO; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\2. 实现相关代理方法,将捕捉到的人脸数据传递给layer层 |

||||||

|

|

||||||

|

```text |

||||||

|

- (void)captureOutput:(AVCaptureOutput *)output didOutputMetadataObjects:(NSArray<__kindof AVMetadataObject *> *)metadataObjects fromConnection:(AVCaptureConnection *)connection { |

||||||

|

|

||||||

|

//metadataObjects包含了捕获到的人脸数据(人脸数据会重复, 会一直捕获人脸数据) |

||||||

|

for (AVMetadataFaceObject *face in metadataObjects) { |

||||||

|

NSLog(@"Face ID:%li",(long)face.faceID); |

||||||

|

} |

||||||

|

//将人脸数据通过代理发送给外部的layer层 |

||||||

|

[self.faceDetectionDelegate didDetectFaces:metadataObjects]; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\3. 配置相关显示的图层。在layer层的视图中配置图层,我们在人脸四周添加一个矩形是在这个AVCaptureVideoPreviewLayer上进行一个个添加矩形。(因为人脸在识别过程中会出现旋转抖动等,需要进行一些3D转换等操作,后续也会出现此类操作,不在此篇作过多讲解) |

||||||

|

|

||||||

|

```text |

||||||

|

- (void)setupView { |

||||||

|

|

||||||

|

//用来记录人脸图层 |

||||||

|

self.faceLayers = [NSMutableDictionary dictionary]; |

||||||

|

//图层的填充方式: 设置videoGravity 使用AVLayerVideoGravityResizeAspectFill 铺满整个预览层的边界范围 |

||||||

|

self.previewLayer.videoGravity = AVLayerVideoGravityResizeAspectFill; |

||||||

|

//在previewLayer上添加一个透明的图层 |

||||||

|

self.overlayLayer = [CALayer layer]; |

||||||

|

self.overlayLayer.frame = self.bounds; |

||||||

|

//假设你的图层上的图形会发生3D变换, 设置投影方式 |

||||||

|

self.overlayLayer.sublayerTransform = CATransform3DMakePerspective(1000); |

||||||

|

[self.previewLayer addSublayer:self.overlayLayer]; |

||||||

|

} |

||||||

|

static CATransform3D CATransform3DMakePerspective(CGFloat eyePosition) { |

||||||

|

//CATransform3D 图层的旋转,缩放,偏移,歪斜和应用的透 |

||||||

|

//CATransform3DIdentity是单位矩阵,该矩阵没有缩放,旋转,歪斜,透视。该矩阵应用到图层上,就是设置默认值。 |

||||||

|

CATransform3D transform = CATransform3DIdentity; |

||||||

|

//透视效果(就是近大远小),是通过设置m34 m34 = -1.0/D 默认是0.D越小透视效果越明显 |

||||||

|

//D:eyePosition 观察者到投射面的距离 |

||||||

|

transform.m34 = -1.0/eyePosition; |

||||||

|

|

||||||

|

return transform; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

\4. 处理通过代理传递过来的人脸数据 |

||||||

|

|

||||||

|

\1. 将人脸在摄像头中的坐标转化为屏幕坐标 |

||||||

|

|

||||||

|

\2. 定义一个数组,保存所有的人脸数据,用于存放待从屏幕上删除的人脸数据 |

||||||

|

|

||||||

|

\3. 遍历人脸数据 |

||||||

|

|

||||||

|

\1. 通过对比屏幕上的layer(框框)数量来与传递过来的人脸进行对比,判断是否需要移除layer(框框) |

||||||

|

|

||||||

|

\2. 根据人脸数据的ID来从屏幕上的layer(框框)中查找是否已经存在,不存在则需要生成一个layer(框框),并更新屏幕的layer(框框)数组。 |

||||||

|

|

||||||

|

\3. 根据传递过来的人脸数据来设置layer(框框)的位置,注意:当最后一个人脸离开屏幕,此时代理方法不会调用,会导致最后一个layer(框框)仍停留在屏幕上,所以需要处理一下人脸将要离开屏幕就对其进行移除处理。 |

||||||

|

|

||||||

|

\4. 在捕捉过程中,人脸会左右前后摆动(即z、y轴变化),来做不同的处理 |

||||||

|

|

||||||

|

\4. 遍历一下待删除数组,将之与传递过来的人脸数据进行对比,删除多余的人脸数据 |

||||||

|

|

||||||

|

注意:此处省略了一些3D转换的方法 |

||||||

|

|

||||||

|

```text |

||||||

|

- (void)didDetectFaces:(NSArray *)faces { |

||||||

|

//人脸数据位置信息(摄像头坐标系)转换为屏幕坐标系 |

||||||

|

NSArray *transfromedFaces = [self transformedFacesFromFaces:faces]; |

||||||

|

|

||||||

|

//人脸消失, 删除图层 |

||||||

|

|

||||||

|

//需要删除的人脸数据列表 |

||||||

|

NSMutableArray *lostFaces = [self.faceLayers.allValues mutableCopy]; |

||||||

|

|

||||||

|

//遍历每个人脸数据 |

||||||

|

for (AVMetadataFaceObject *face in transfromedFaces) { |

||||||

|

|

||||||

|

//face ID |

||||||

|

NSNumber *faceID = @(face.faceID); |

||||||

|

//face ID存在即不需要删除(从删除列表中移除) |

||||||

|

[lostFaces removeObject:faceID]; |

||||||

|

|

||||||

|

//假如有新的人脸加入 |

||||||

|

CALayer *layer = self.faceLayers[faceID]; |

||||||

|

if (!layer) { |

||||||

|

NSLog(@"新增人脸"); |

||||||

|

layer = [self makeFaceLayer]; |

||||||

|

[self.overlayLayer addSublayer:layer]; |

||||||

|

|

||||||

|

//更新字典 |

||||||

|

self.faceLayers[faceID] = layer; |

||||||

|

} |

||||||

|

|

||||||

|

//根据人脸的bounds设置layer的frame |

||||||

|

layer.frame = face.bounds; |

||||||

|

CGSize size = self.bounds.size; |

||||||

|

//当人脸特别靠近屏幕边缘, 直接当作无法识别此人脸(因为人脸离开屏幕不会走此代理方法, 需要提前做移除) |

||||||

|

if (face.bounds.origin.x < 3 || |

||||||

|

face.bounds.origin.x > size.width - layer.frame.size.width - 3 || |

||||||

|

face.bounds.origin.y < 3 || |

||||||

|

face.bounds.origin.y > size.height - layer.frame.size.height - 3 ) { |

||||||

|

[layer removeFromSuperlayer]; |

||||||

|

[self.faceLayers removeObjectForKey:faceID]; |

||||||

|

} |

||||||

|

|

||||||

|

//设置3D属性(人脸是3D的, 需要根据人脸的3D变化做不同的变化处理) |

||||||

|

layer.transform = CATransform3DIdentity; |

||||||

|

//人脸z轴变化 |

||||||

|

if (face.hasRollAngle) { |

||||||

|

CATransform3D t = [self transformForRollAngle:face.rollAngle]; |

||||||

|

//矩阵相乘 |

||||||

|

layer.transform = CATransform3DConcat(layer.transform, t); |

||||||

|

} |

||||||

|

//人脸y轴变化 |

||||||

|

if (face.hasYawAngle) { |

||||||

|

CATransform3D t = [self transformForYawAngle:face.hasYawAngle]; |

||||||

|

//矩阵相乘 |

||||||

|

layer.transform = CATransform3DConcat(layer.transform, t); |

||||||

|

} |

||||||

|

} |

||||||

|

//处理已经从镜头消失的人脸(人脸消失,图层并没有消失) |

||||||

|

for (NSNumber *faceID in lostFaces) { |

||||||

|

CALayer *layer = self.faceLayers[faceID]; |

||||||

|

[self.faceLayers removeObjectForKey:faceID]; |

||||||

|

[layer removeFromSuperlayer]; |

||||||

|

} |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

### **2.1、其他类型数据的识别** |

||||||

|

|

||||||

|

有的同学在设置AVMetadataObjectTypeFace的可能会发现,还有会有一些其他的类型,例如AVMetadataObjectTypeQRCode等,就是从摄像头中捕获二维码数据,它的流程与人脸识别极度相似,甚至要更为简单一些,因为二维码并不像人脸一样需要做一些3D的转换等操作,所以此处不再示例捕捉二维码。 |

||||||

|

|

||||||

|

原文https://zhuanlan.zhihu.com/p/222418988 |

||||||

@ -0,0 +1,107 @@ |

|||||||

|

# iOS音视频同步探讨 |

||||||

|

|

||||||

|

## 1.音视频同步的原理 |

||||||

|

|

||||||

|

音视频采集的数据分别来自于麦克风与摄像头,而摄像头与麦克风其实是两个独立的硬件,而音视频同步的原理是相信摄像头与麦克风采集数据是实时的,并在采集到数据时给他们一个时间戳来标明数据所属的时间,而编码封装模块只要不改动音视频时间的相对关系就能保证音频与视频在时间上的对应。如此封装好数据之后,播放端就能够根据音视频的时间戳来播放对应的音视频,从实现音视频同步的效果。 |

||||||

|

|

||||||

|

## 2.时间戳参考标准 |

||||||

|

|

||||||

|

- 取格林威治时间做为对比标准,即音视频时间戳都为采集时间点相对于格林威治标准时间的时间差 |

||||||

|

- 取系统开机时间做为对比标准,即音视频时间戳都是采集时间点相对于手机开机时间的时间差。目前iOS上AVCaptureSession这套API就是参考这个时间标准给的时间戳 |

||||||

|

- 其它时间戳标准 |

||||||

|

|

||||||

|

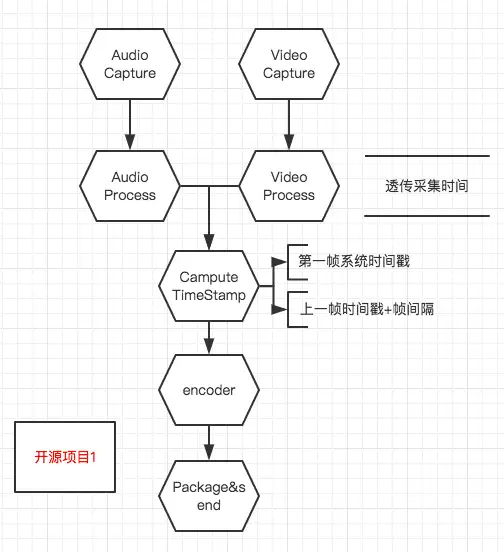

## 3.基于“开源项目1”的音视频同步探讨 |

||||||

|

|

||||||

|

- 原生某开源框架 |

||||||

|

|

||||||

|

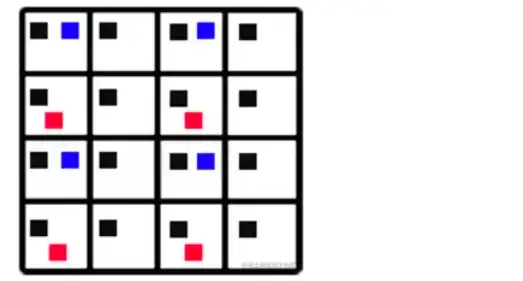

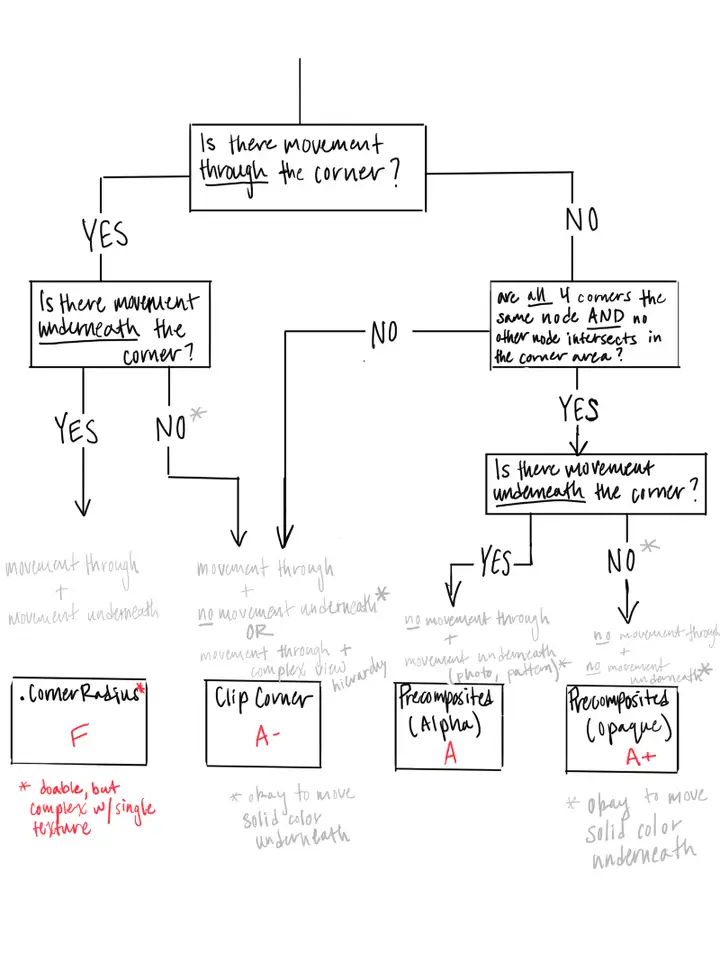

- - 如图: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- - 简介 |

||||||

|

|

||||||

|

- - 音/视频被采集到之后会先经过音/视频处理模块,音/视频在被处理之后才进入计算时间戳的模块 |

||||||

|

- 在第一帧到达时记一个计时起点,然后根据采集的帧间隔对接下来每一帧的时间戳进行计算:frameTimeStamp = lastFrameTimeStamp + frameDuration |

||||||

|

|

||||||

|

- 优点 |

||||||

|

|

||||||

|

- - 能输出**frame duration**稳定的音视频时间戳 |

||||||

|

|

||||||

|

- 风险 |

||||||

|

|

||||||

|

- - 无论是音频还是视频,在手机过热、性能不足等极端情况下有可能出现采集不稳定的情况,比如说预计1s采集30帧,实际只采集到28帧,而音视频的时间戳是通过累加来计算的,这样就有会出现音视频不同步的情况 |

||||||

|

- **Video Process**(人脸检测、滤镜、3D贴纸)有可能无法在一帧时间内处理完当前帧,这样就会出现帧数比预期低的情况,从而出现音视频不同步 |

||||||

|

- 帧间隔涉及到无限小数时,因为计算机的精度有限会引发的时间戳偏移,此偏移会随着帧数的增加而逐渐被放大 |

||||||

|

|

||||||

|

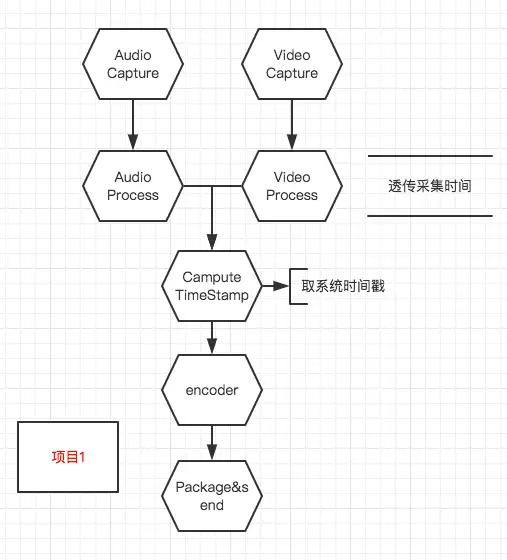

- 基于**开源项目1**的改进方案1 |

||||||

|

|

||||||

|

- - 如图: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- 简介 |

||||||

|

|

||||||

|

- - - 音/视频被采集到之后会先经过音/视频处理模块,音/视频在被处理之后才进入计算时间戳的模块 |

||||||

|

- 时间戳的获取方法非常直接——每一帧都在改帧进入时间戳计算模块时获取当前系统时间作为时间戳 |

||||||

|

|

||||||

|

- 优点: |

||||||

|

|

||||||

|

- - APP性能正常的情况下肯定不会出现音视频不同步 |

||||||

|

- 能够实时纠正时间戳,只要APP正常运转,就能立即恢复正确的时间戳 |

||||||

|

|

||||||

|

- 风险: |

||||||

|

|

||||||

|

- - 依赖**Video Process**与**Audio Process**模块处理时长相近,而实际工程中因为人脸检测、贴纸等原因,**Video Process**可能会出现阻塞的情况,从而导致临时性的音视频不同步 |

||||||

|

- 在**Audio Process**与**Video Process**模块处理帧耗时不均匀的情况下会出现音视频时间戳不均匀的问题,能否正常播放依赖于终端 |

||||||

|

|

||||||

|

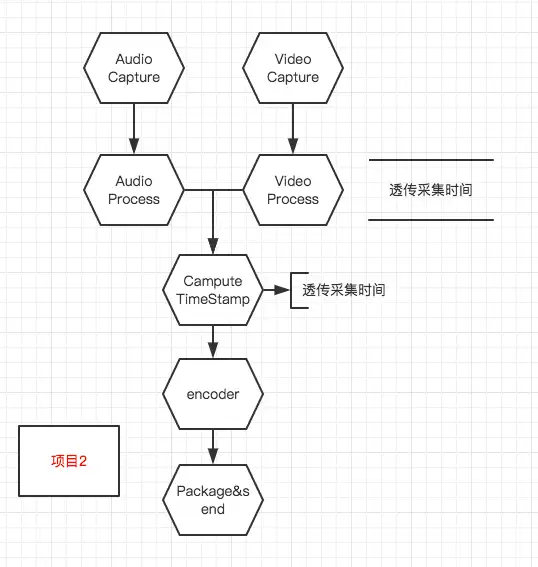

- 基于**开源项目1**的一个改进方案2 |

||||||

|

|

||||||

|

- - 如图: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- 简介 |

||||||

|

|

||||||

|

- - - 音/视频被采集到之后,先获取采集模块提供的音视频时间戳,然后在音/视频处理模块透传采集模块获取到的音/视频时间戳,在时间戳计算模块继续透传采集模块给的时间戳 |

||||||

|

|

||||||

|

- 优点: |

||||||

|

|

||||||

|

- - 除非采集模块给出错误数据,否则音视频都一定是同步的 |

||||||

|

|

||||||

|

- 风险: |

||||||

|

|

||||||

|

- - 可能会出现音视频时间戳不均匀的情况,尤其是在手机过热、性能不足等极端情况下 |

||||||

|

|

||||||

|

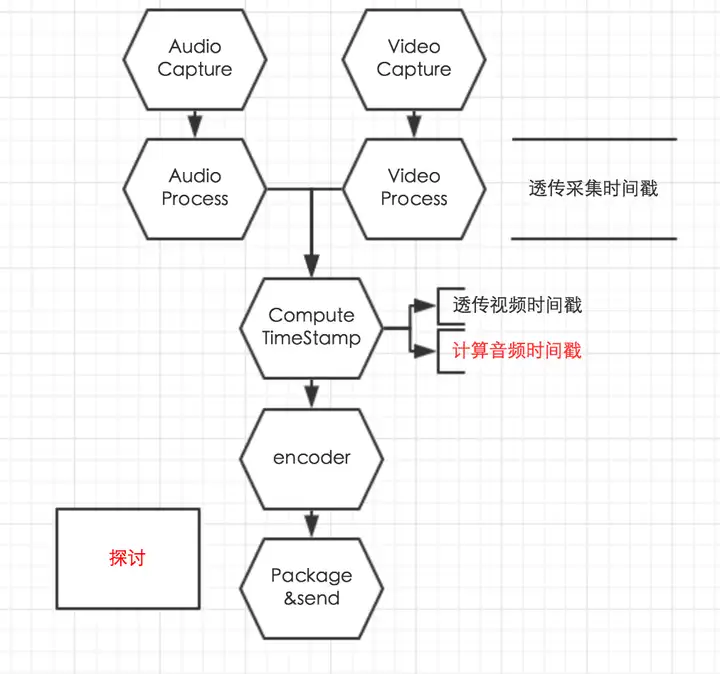

- 直播方向更进一步的优化探讨 |

||||||

|

|

||||||

|

- - 大致流程如图: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- 简介 |

||||||

|

|

||||||

|

- - - - 音/视频被采集到之后,先获取采集模块提供的音视频时间戳,然后在音/视频处理模块透传采集模块获取到的音/视频时间戳 |

||||||

|

- 在时间戳计算模块透传视频时间戳,并根据下文中提到的方法计算音频时间戳 |

||||||

|

|

||||||

|

- 音频时间戳计算方法 |

||||||

|

|

||||||

|

- - 实时计算时间戳:当前时间戳=起始时间戳+帧数*帧采样数/采样率 |

||||||

|

- 如果时间戳偏移量超出阈值,纠正时间戳 |

||||||

|

- 纠正频率达到超出阈值,直接透传采集时间戳 |

||||||

|

|

||||||

|

- 优点: |

||||||

|

|

||||||

|

- - 能够提供一个稳定的音频时间戳,可以兼容帧间隔小幅抖动造成的音频时间戳不均匀 |

||||||

|

- 兼容性能不足时导致实际采集帧数低于帧率 |

||||||

|

|

||||||

|

- 风险 |

||||||

|

|

||||||

|

- - 纠正时间戳时可能会造成声音卡顿的感觉 |

||||||

|

|

||||||

|

- 总结 |

||||||

|

|

||||||

|

- - 具体方案最好是针对实际应用场景有选择性的做优化,比如说,在可以控制播放器策略的情况,可以考虑根据自研播放器特性做时间戳处理。而如果播放器不可控,则尽量通过策略保障帧间隔稳定。 |

||||||

|

|

||||||

|

原文https://zhuanlan.zhihu.com/p/28557179 |

||||||

@ -0,0 +1,260 @@ |

|||||||

|

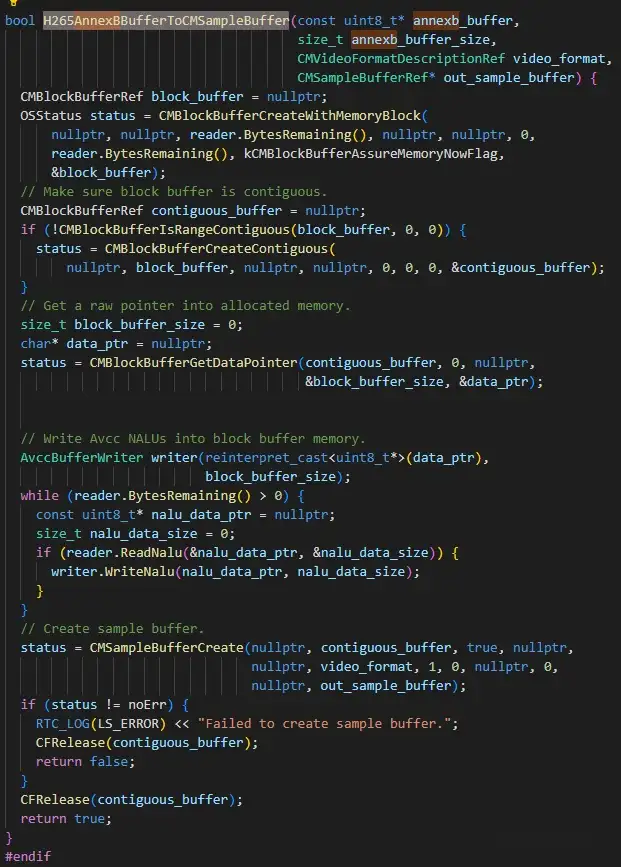

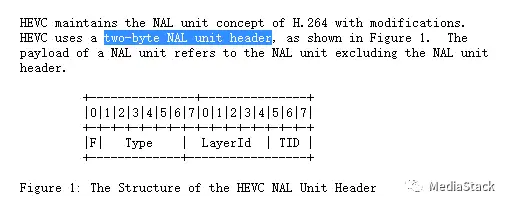

# iOS音视频开发-了解编码及视频 |

||||||

|

|

||||||

|

## 1. 视频H264编码 |

||||||

|

|

||||||

|

### 1.1 为何编码? |

||||||

|

|

||||||

|

从存储角度和网络传输以及通用性 3个角度,压缩已经成了不可或缺的动作.压缩编码最基本的指标,就是压缩比. 压缩比通常都是小于1(如果等于或者大于1,是不是就失去了编码的意义了.编码的目的就是为了压缩数据体量). |

||||||

|

|

||||||

|

### 1.2 何为编码? |

||||||

|

|

||||||

|

编码就是按照一定的格式记录采样和量化后的数据. |

||||||

|

|

||||||

|

#### 1.2.1编码中软编码和硬编码的区别? |

||||||

|

|

||||||

|

- 硬编码: 使用非CPU进行编码,例如使用GPU芯片处理 |

||||||

|

- 软编码: 使用CPU来进行编码计算. |

||||||

|

|

||||||

|

#### 1.2.2 软编码与硬编码的区分? |

||||||

|

|

||||||

|

- 软编码: 实现直接、简单,参数调整方便,升级易,但CPU负载重,性能较硬编码低,低码率下质量通常比硬编码要好一点。 |

||||||

|

- 硬编码:性能高,低码率下通常质量低于硬编码器,但部分产品在GPU硬件平台移植了优秀的软编码算法(如X264)的,质量基本等同于软编码。 |

||||||

|

- 硬编码,就是使用GPU计算,获取数据结果,优点速度快,效率高.\ |

||||||

|

- 软编码,就是通过CPU来计算,获取数据结果. |

||||||

|

|

||||||

|

#### 1.2.3 压缩算法 |

||||||

|

|

||||||

|

**压缩算法分为2种,有损压缩与无损压缩.** |

||||||

|

|

||||||

|

- 无损压缩:解压后的数据可以完全复原,在常用的压缩格式中,无损压缩使用频次较低 |

||||||

|

- 有损压缩:解压后数据不能完全复原,会丢失一部分信息.压缩比越小,丢失的信息就会越多.信号还原的失真就会越大. |

||||||

|

|

||||||

|

**需要根据不同的场景(考虑因素包括存储设备,传输网络环境,播放设备等)选用不同的压缩编码算法.** |

||||||

|

|

||||||

|

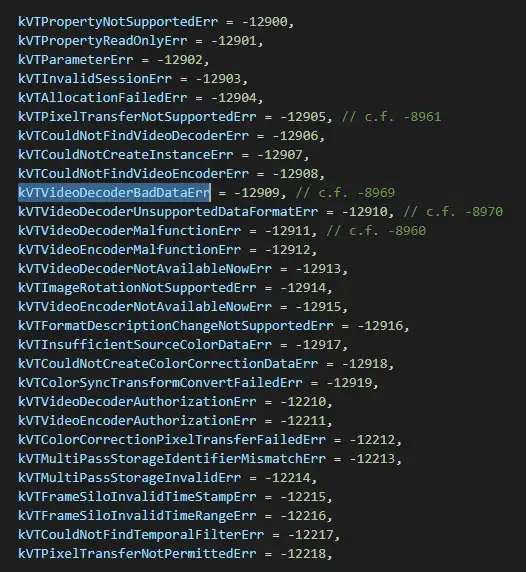

### 1.3 VideoToolBox 硬编码 |

||||||

|

|

||||||

|

VideoToolbox 是一套纯C语言API。其中包含了很多C语言函数 |

||||||

|

|

||||||

|

VideoToolBox实际上属于低级框架,它是可以直接访问硬件编码器和解码器.它存在于视频压缩和解压缩以及存储在像素缓存区中的数据转换提供服务. |

||||||

|

|

||||||

|

**硬编码的优点:提高性能、增加效率、延长电量的使用** |

||||||

|

|

||||||

|

## 2.了解视频 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

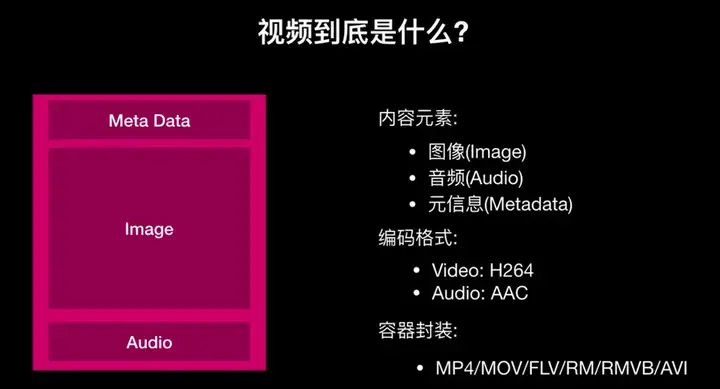

### 2.1视频的构成: |

||||||

|

|

||||||

|

- 图像 |

||||||

|

- 音频 |

||||||

|

- 元信息 |

||||||

|

|

||||||

|

**图像:** 视频内容本身就是一帧一帧的图片构成.人眼只要1秒钟连续播放16张以上的图片,就会认为这是一段连贯的视频.这种物理现象叫视觉暂留. |

||||||

|

|

||||||

|

**音频:** 视频一定是由音频+图像内容构成的.所以音频在视频中是单独的一个部分.针对这一块我们需要单独编码的. |

||||||

|

|

||||||

|

**元信息:** 元信息其实就是描述信息的信息.用于描述信息的结构\语义\用途\用法等.比如视频元信息就包含了视频的具体信息,比如编码格式,分辨率等等. |

||||||

|

|

||||||

|

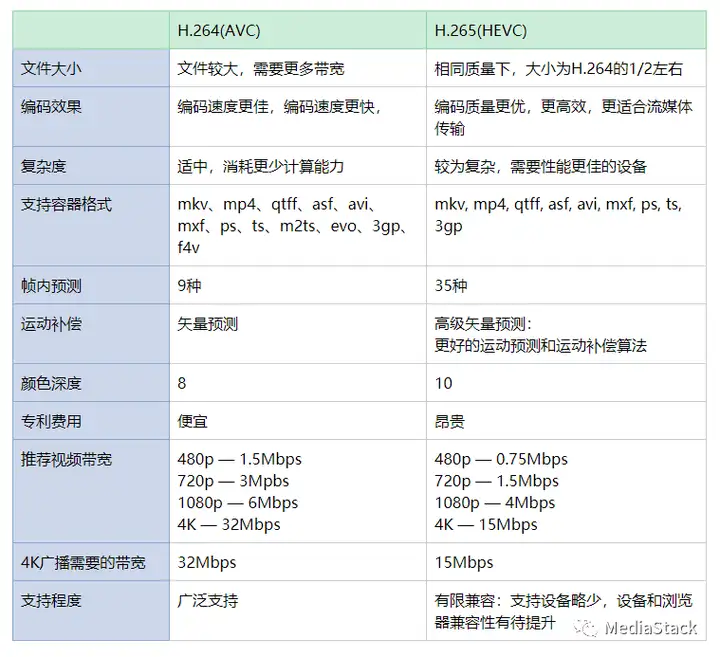

### 2.2视频中的编码格式 |

||||||

|

|

||||||

|

- **视频编码格式** |

||||||

|

|

||||||

|

- - H264编码的优势: |

||||||

|

|

||||||

|

- - 低码率 |

||||||

|

- 高质量的图像 |

||||||

|

- 容错能力强 |

||||||

|

- 网络适应性强 |

||||||

|

|

||||||

|

- **总结:** H264最大的优势,具有很高的数据压缩比率,在同等图像质量下,H264的压缩比是MPEG-2的2倍以上,MPEG-4的1.5~2倍. |

||||||

|

|

||||||

|

- **举例:** 原始文件的大小如果为88GB,采用MPEG-2压缩标准压缩后变成3.5GB,压缩比为25∶1,而采用H.264压缩标准压缩后变为879MB,从88GB到879MB,H.264的压缩比达到惊人的102∶1 |

||||||

|

|

||||||

|

- **音频编码格式:** |

||||||

|

|

||||||

|

- - AAC是目前比较热门的有损压缩编码技术,并且衍生了LC-AAC,HE-AAC,HE-AAC v2 三种主要编码格式. |

||||||

|

|

||||||

|

- - LC-AAC 是比较传统的AAC,主要应用于中高码率的场景编码(>= 80Kbit/s) |

||||||

|

- HE-AAC 主要应用于低码率场景的编码(<= 48Kbit/s) |

||||||

|

|

||||||

|

- **优势**:在小于128Kbit/s的码率下表现优异,并且多用于视频中的音频编码 |

||||||

|

|

||||||

|

- **适合场景**:于128Kbit/s以下的音频编码,多用于视频中的音频轨的编码 |

||||||

|

|

||||||

|

### 2.3 容器(视频封装格式) |

||||||

|

|

||||||

|

**封装格式:** 就是将已经编码压缩好的视频数据 和音频数据按照一定的格式放到一个文件中.这个文件可以称为容器. 当然可以理解为这只是一个外壳. |

||||||

|

|

||||||

|

通常我们不仅仅只存放音频数据和视频数据,还会存放 一下视频同步的元数据.例如字幕.这多种数据会不同的程序来处理,但是它们在传输和存储的时候,这多种数据都是被绑定在一起的. |

||||||

|

|

||||||

|

- **常见的视频容器格式**: |

||||||

|

|

||||||

|

- - AVI: 是当时为对抗quicktime格式(mov)而推出的,只能支持固定CBR恒定定比特率编码的声音文件 |

||||||

|

- MOV:是Quicktime封装 |

||||||

|

- WMV:微软推出的,作为市场竞争 |

||||||

|

- mkv:万能封装器,有良好的兼容和跨平台性、纠错性,可带外挂字幕 |

||||||

|

- flv: 这种封装方式可以很好的保护原始地址,不容易被下载到,目前一些视频分享网站都采用这种封装方式 |

||||||

|

- MP4:主要应用于mpeg4的封装,主要在手机上使用。 |

||||||

|

|

||||||

|

## 3.视频压缩的可能性 |

||||||

|

|

||||||

|

视频压缩,该从那几个方向去进行数据的压缩了? 实际上压缩的本质都是从冗余信息开始出发压缩的. 而视频数据之间是有极强的相关性.也就是这样会产生大量的冗余信息.这样的冗余包括空间上的冗余信息和时间上的冗余信息. |

||||||

|

|

||||||

|

- **使用帧间编码技术可以去除时间上的冗余信息,具体包括如下** |

||||||

|

|

||||||

|

- - **运动补偿**: 运动补偿是通过先前的局部图形来预测,补偿当前的局部图像.它是减少帧序列冗余信息很有效的方法. |

||||||

|

- **运动表示**: 不同区域的图像需要使用不同的运动矢量来描述运动信息 |

||||||

|

- **运动估计**: 运动估计就是从视频序列中抽取运动信息的一整套技术. |

||||||

|

|

||||||

|

### 3.1 编码概念 |

||||||

|

|

||||||

|

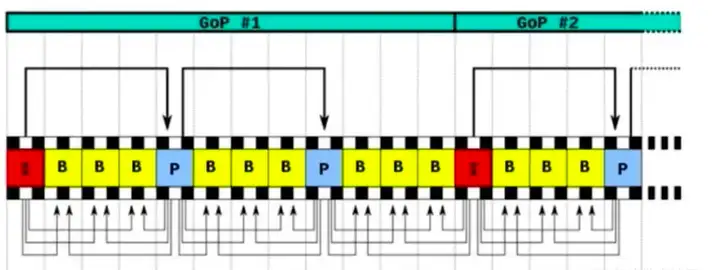

**IPB帧** |

||||||

|

视频压缩中,每帧代表着一副静止的图像.而进行实际压缩时,会采用各种算法以减少数据的容量.其实IPB帧是最常用的一种方式: |

||||||

|

|

||||||

|

- **I帧**:**关键帧,采用帧内压缩技术**.帧内编码帧(intra picture),I帧通常是每个GOP(MPEG所使用的一种视频压缩技术)的第一帧.经过适度的压缩.作为随机访问的参考点,可以当做静态图像.I帧可以看做一个图像经过压缩后的产物.I帧压缩可以得到6:1的压缩比而不会产生任何可察觉的模糊现象.I帧压缩去除了视频空间的冗余信息. |

||||||

|

- **P帧**:**向前参考帧.压缩时只参考前一个帧.属于帧间压缩技术**. 前后预测编码帧(predictive-frame),通过将图像序列中前面已编码帧的时间冗余信息充分去除来压缩传输数据量的编码图像. |

||||||

|

- **B帧**:**双向参考帧,压缩时即参考前一帧也参考后一帧.帧间压缩技术.** 双向预测编码帧(bi-directional interpolated prediction frame),既要考虑源图像序列前面已编码帧,又要顾及源图像序列后面的已编码帧之间的时间冗余信息,来压缩传输数据量的编码图像. |

||||||

|

|

||||||

|

**读者角度解读** |

||||||

|

|

||||||

|

- **I帧**,自身可以通过视频解码算法解压成一张单独的完整的视频画面.所以I帧去掉的是视频帧在空间维度上的冗余信息. |

||||||

|

- **P帧**,需要参考前面的一个I帧或P帧解码成一个完整的视频画面 |

||||||

|

- **B帧**,需要参考前面的一个I帧或者P帧以及后面的一个P帧来生成一个完整的视频画面. |

||||||

|

- **所以,P和B帧去掉的视频帧在时间上维度上的冗余信息**. |

||||||

|

|

||||||

|

### 3.2 解码中PTS 与 DTS |

||||||

|

|

||||||

|

**DTS(Decoding Time Stamp)** ,主要用于视频的解码; |

||||||

|

**PTS(Presentation Time Stamp)** ,主要用于解码节点进行视频的同步和输出. |

||||||

|

|

||||||

|

在没有B帧的情况下,DTS和PST的输出顺序是一样的.因为B帧会打乱了解码和显示顺序.所以一旦存在B帧,PTS和DTS势必会不同.实际上在大多数编解码标准中,编码顺序和输入顺序并不一致.于是需要PTS和DST这2种不同的时间戳. |

||||||

|

|

||||||

|

### 3.3 GOP概念 |

||||||

|

|

||||||

|

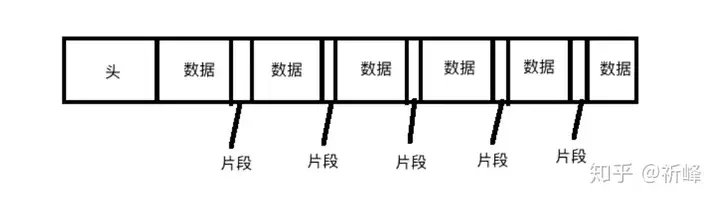

**两个I帧之间形成的一组图片,就是GOP(Group of Picture).** |

||||||

|

通常在编码器设置参数时,必须会设置gop_size的值.其实就是代表2个I帧之间的帧数目. 在一个GOP组中容量最大的就是I帧.所以相对而言,gop_size设置的越大,整个视频画面质量就会越好.但是解码端必须从接收的第一个I帧开始才可以正确解码出原始图像.否则无法正确解码. 如果在一秒钟内,有30帧.这30帧可以画成一组.如果摄像机或者镜头它一分钟之内它都没有发生大的变化.那也可以把这一分钟内所有的帧画做一组. |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

**一组帧**就是一个I帧到下一个I帧.这一组的数据.包括B帧/P帧. |

||||||

|

|

||||||

|

### 3.3 SPS/PPS |

||||||

|

|

||||||

|

SPS/PPS实际上就是存储GOP的参数. |

||||||

|

|

||||||

|

**SPS: (Sequence Parameter Set,序列参数集)存放帧数,参考帧数目,解码图像尺寸,帧场编码模式选择标识等**. |

||||||

|

|

||||||

|

- 一组帧的参数集. |

||||||

|

|

||||||

|

**PPS:(Picture Parameter Set,图像参数集).存放熵编码模式选择标识,片组数目,初始量化参数和去方块滤波系数调整标识等.(与图像相关的信息)** |

||||||

|

|

||||||

|

在一组帧之前我们首先收到的是SPS/PPS数据.如果没有这组参数的话,我们是无法解码. |

||||||

|

|

||||||

|

如果我们在解码时发生错误,首先要检查是否有SPS/PPS.如果没有,是因为对端没有发送过来还是因为对端在发送过程中丢失了. |

||||||

|

|

||||||

|

SPS/PPS数据,我们也把其归类到I帧.这2组数据是绝对不能丢的. |

||||||

|

|

||||||

|

## 4. 视频花屏/卡顿原因 |

||||||

|

|

||||||

|

我们在观看视频时,会遇到花屏或者卡顿现象.那这个与我们刚刚所讲的GOF就息息相关了. |

||||||

|

|

||||||

|

- 如果GOP分组中的P帧丢失就会造成解码端的图像发生错误. |

||||||

|

- 为了避免花屏问题的发生,一般如果发现P帧或者I帧丢失.就不显示本GOP内的所有帧.只到下一个I帧来后重新刷新图像. |

||||||

|

- 当这时因为没有刷新屏幕.丢包的这一组帧全部扔掉了.图像就会卡在哪里不动.这就是卡顿的原因. |

||||||

|

|

||||||

|

**所以总结起来,花屏是因为你丢了P帧或者I帧.导致解码错误. 而卡顿是因为为了怕花屏,将整组错误的GOP数据扔掉了.直达下一组正确的GOP再重新刷屏.而这中间的时间差,就是我们所感受的卡顿.** |

||||||

|

|

||||||

|

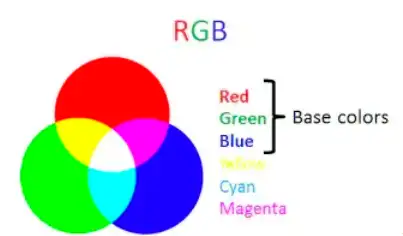

## 5.颜色模型 |

||||||

|

|

||||||

|

我们开发场景中使用最多的应该是 RGB 模型 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

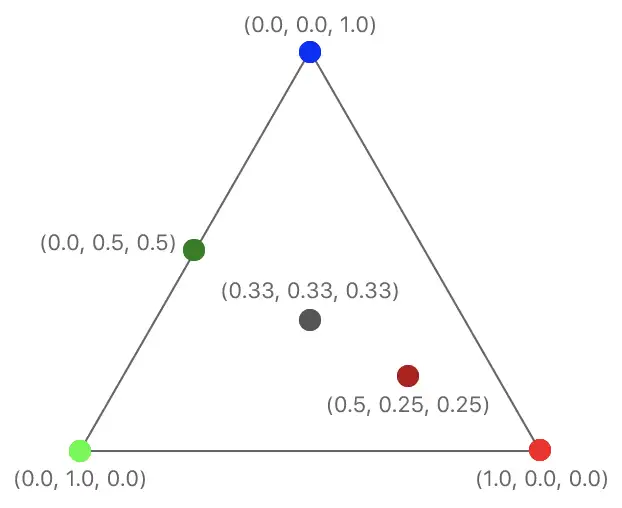

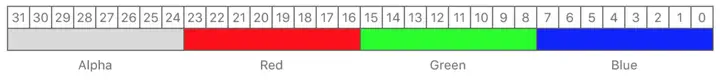

在 RGB 模型中每种颜色需要 3 个数字,分别表示 R、G、B,比如 (255, 0, 0) 表示红色,通常一个数字占用 1 字节,那么表示一种颜色需要 24 bits。那么有没有更高效的颜色模型能够用更少的 bit 来表示颜色呢? |

||||||

|

|

||||||

|

现在我们假设我们定义一个**「亮度(Luminance)」**的概念来表示颜色的亮度,那它就可以用含 R、G、B 的表达式表示为: |

||||||

|

|

||||||

|

```text |

||||||

|

Y = kr*R + kg*G + kb*B |

||||||

|

``` |

||||||

|

|

||||||

|

Y 即「亮度」,kr、kg、kb 即 R、G、B 的权重值。 |

||||||

|

|

||||||

|

这时,我们可以定义一个**「色度(Chrominance)」**的概念来表示颜色的差异: |

||||||

|

|

||||||

|

```text |

||||||

|

Cr = R – Y |

||||||

|

Cg = G – Y |

||||||

|

Cb = B – Y |

||||||

|

``` |

||||||

|

|

||||||

|

Cr、Cg、Cb 分别表示在 R、G、B 上的色度分量。上述模型就是 **YCbCr** 颜色模型基本原理。 |

||||||

|

|

||||||

|

**YCbCr** 是属于 **YUV** 家族的一员,是在计算机系统中应用最为广泛的颜色模型,就比如在本文所讲的视频领域。***在 YUV 中 Y 表示的是「亮度」,也就是灰阶值,U 和 V 则是表示「色度」。\*** |

||||||

|

|

||||||

|

**YUV 的关键是在于它的亮度信号 Y 和色度信号 U、V 是分离的。那就是说即使只有 Y 信号分量而没有 U、V 分量,我们仍然可以表示出图像,只不过图像是黑白灰度图像**。在YCbCr 中 Y 是指亮度分量,Cb 指蓝色色度分量,而 Cr 指红色色度分量。 |

||||||

|

|

||||||

|

现在我们从 ITU-R BT.601-7 标准中拿到推荐的相关系数,就可以得到 YCbCr 与 RGB 相互转换的公式 |

||||||

|

|

||||||

|

```text |

||||||

|

Y = 0.299R + 0.587G + 0.114B |

||||||

|

Cb = 0.564(B - Y) |

||||||

|

Cr = 0.713(R - Y) |

||||||

|

R = Y + 1.402Cr |

||||||

|

G = Y - 0.344Cb - 0.714Cr |

||||||

|

B = Y + 1.772Cb |

||||||

|

``` |

||||||

|

|

||||||

|

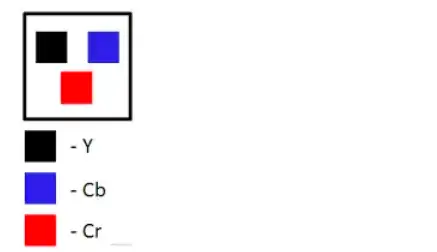

这样对于 **YCbCr** 这个颜色模型我们就有个初步认识了,但是我们会发现,这里 **YCbCr** 也仍然用了 3 个数字来表示颜色啊,有节省 **bit** 吗?为了回答这个问题,我们来结合视频中的图像和图像中的像素表示来说明 |

||||||

|

|

||||||

|

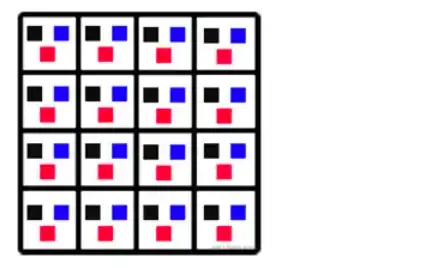

- 假设图片有如下像素组成 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

一副图片就是一个像素阵列.每个像素的 3 个分量的信息是完整的,**YCbCr 4:4:4**。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

下图中,对于每个像素点都保留「亮度」值,但是省略每行中偶素位像素点的「色度」值,从而节省了 bit。**YCbCr4:2:2** |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

上图,做了更多的省略,但是对图片质量的影响却不会太大.**YCbCr4:2:0** |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 6. 音频编码 |

||||||

|

|

||||||

|

常用压缩编码格式 |

||||||

|

|

||||||

|

WAV编码 |

||||||

|

|

||||||

|

WAV编码的一种实现方式(其实它有非常多实现方式,但都是不会进行压缩操作).就是在源PCM数据格式的前面加上44个字节.分别用来描述PCM的采样率,声道数,数据格式等信息. |

||||||

|

|

||||||

|

- 特点:音质非常好,大量软件都支持其播放 |

||||||

|

- 适合场合:多媒体开发的中间文件,保存音乐和音效素材 |

||||||

|

|

||||||

|

MP3编码 |

||||||

|

|

||||||

|

MP3编码具有不错的压缩比,而且听感也接近于WAV文件,当然在不同的环境下,应该调整合适的参数来达到更好的效果. |

||||||

|

|

||||||

|

- 特点:音质在128Kbit/s以上表现不错,压缩比比较高.大量软件和硬件都支持.兼容性高. |

||||||

|

- 适合场合:高比特率下对兼容性有要求的音乐欣赏. |

||||||

|

|

||||||

|

AAC编码 |

||||||

|

|

||||||

|

AAC是目前比较热门的有损压缩编码技术,并且衍生了LC-AAC,HE-AAC,HE-AAC v2 三种主要编码格式. |

||||||

|

|

||||||

|

- LC-AAC 是比较传统的AAC,主要应用于中高码率的场景编码(>= 80Kbit/s) |

||||||

|

- HE-AAC 主要应用于低码率场景的编码(<= 48Kbit/s) |

||||||

|

- 特点:在小于128Kbit/s的码率下表现优异,并且多用于视频中的音频编码 |

||||||

|

- 适合场景:于128Kbit/s以下的音频编码,多用于视频中的音频轨的编码 |

||||||

|

|

||||||

|

Ogg编码 |

||||||

|

|

||||||

|

Ogg编码是一种非常有潜力的编码,在各种码率下都有比较优秀的表现.尤其在低码率场景下.Ogg除了音质好之外,Ogg的编码算法也是非常出色.可以用更小的码率达到更好的音质.128Kbit/s的Ogg比192Kbit/s甚至更高码率的MP3更优质.但目前由软件还是硬件支持问题,都没法达到与MP3的使用广度. |

||||||

|

|

||||||

|

- 特点:可以用比MP3更小的码率实现比MP3更好的音质,高中低码率下均有良好的表现,兼容不够好,流媒体特性不支持. |

||||||

|

- 适合场景:语言聊天的音频消息场景 |

||||||

|

|

||||||

|

原文地址:[iOS音视频开发-了解编码及视频 - 资料 - 我爱音视频网 - 构建全国最权威的音视频技术交流分享论坛]( |

||||||

@ -0,0 +1,288 @@ |

|||||||

|

# iOS音视频开发——视频采集 |

||||||

|

|

||||||

|

## 1.认识 AVCapture 系列 |

||||||

|

|

||||||

|

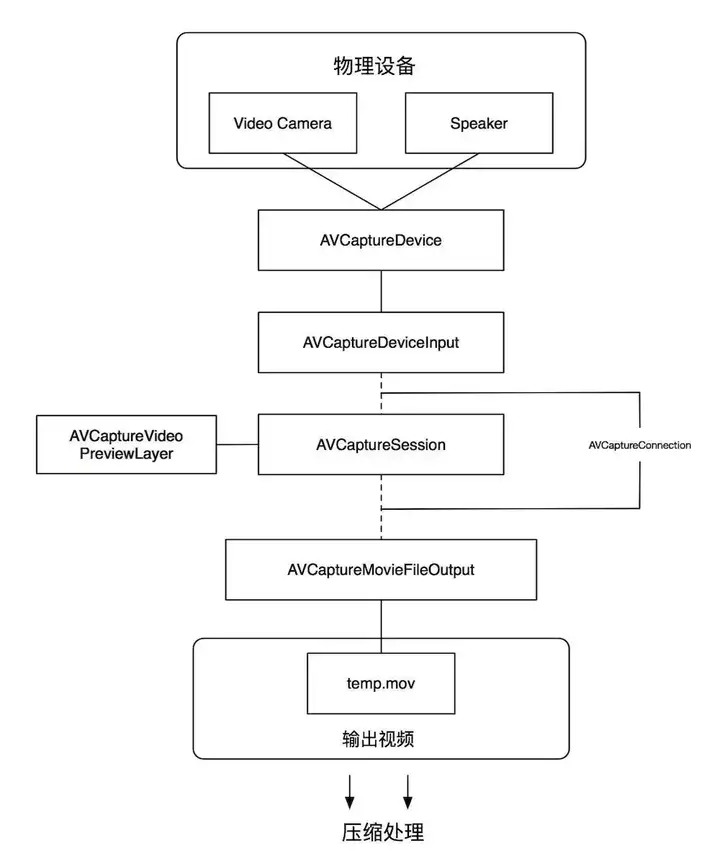

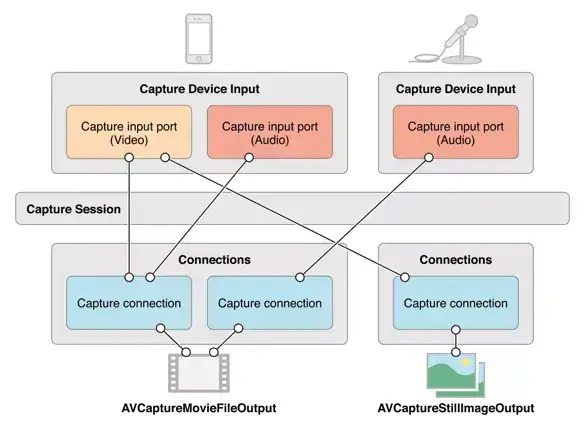

AVCapture 系列是 AVFoundation 框架为我们提供的用于管理输入设备、采集、输出、预览等一系列接口,其工作原理如下: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

\1. AVCaptureDevice: 信号采集硬件设备(摄像头、麦克风、屏幕等) |

||||||

|

`AVCaptureDevice` 代表硬件设备,并且为 `AVCaptureSession` 提供 input,要想使用 `AVCaptureDevice`,应该先将设备支持的 `device` 枚举出来, 根据摄像头的位置( 前置或者后置摄像头 )获取需要用的那个摄像头, 再使用; |

||||||

|

如果想要对 `AVCaptureDevice` 对象的一些属性进行设置,应该先调用 `lockForConfiguration:` 方法, 设置结束后,调用 `unlockForConfiguration` 方法; |

||||||

|

|

||||||

|

```text |

||||||

|

[self.device lockForConfiguration:&error]; |

||||||

|

// 设置 *** |

||||||

|

[self.device unlockForConfiguration]; |

||||||

|

``` |

||||||

|

|

||||||

|

## 2. AVCaptureInput: 输入数据管理 |

||||||

|

|

||||||

|

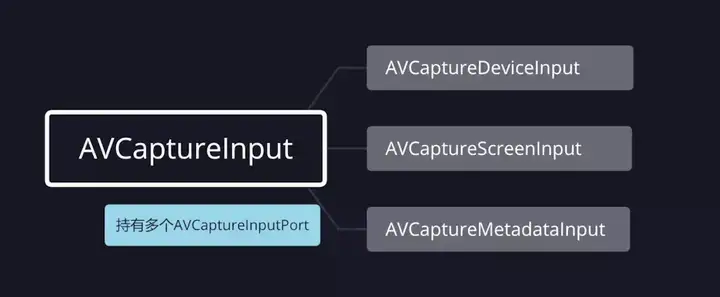

AVCaptureInput 继承自 `NSObject`,是向 `AVCaptureSession` 提供输入数据的对象的抽象超类; |

||||||

|

要将 `AVCaptureInput` 对象与会话 `AVCaptureSession` 关联,需要 `AVCaptureSession`实例调用 `-addInput:` 方法。 |

||||||

|

由于 `AVCaptureInput` 是个抽象类,无法直接使用,所以我们一般使用它的子类类管理输入数据。我们常用的 `AVCaptureInput` 的子类有三个: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

`AVCaptureDeviceInput`:用于从 `AVCaptureDevice` 对象捕获数据; |

||||||

|

`AVCaptureScreenInput`:从 macOS 屏幕上录制的一种捕获输入; |

||||||

|

`AVCaptureMetadataInput`:它为 `AVCaptureSession` 提供 `AVMetadataItems`。 |

||||||

|

|

||||||

|

## 3. AVCaptureOutput:输出数据管理 |

||||||

|

|

||||||

|

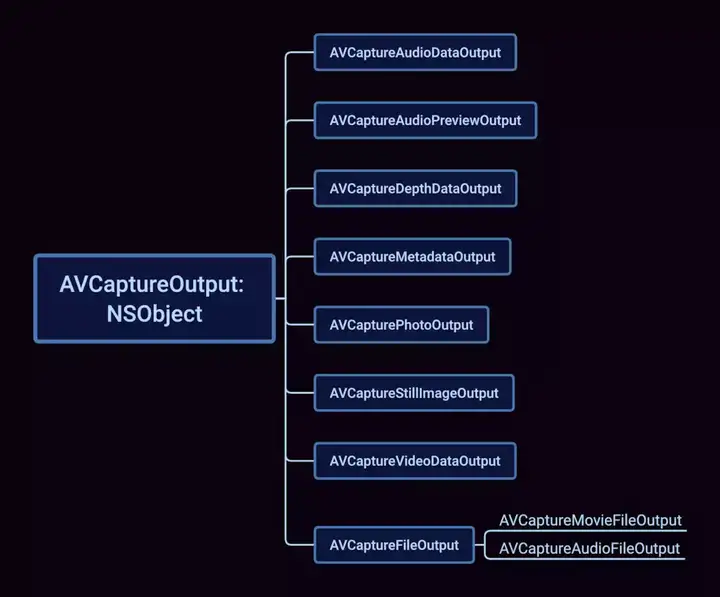

AVCaptureOutput 继承自 `NSObject`,是输出数据管理,该对象将会被添加到会话`AVCaptureSession`中,用于接收会话`AVCaptureSession`各类输出数据; `AVCaptureOutput`提供了一个抽象接口,用于将捕获输出数据(如文件和视频预览)连接到捕获会话`AVCaptureSession`的实例,捕获输出可以有多个由`AVCaptureConnection`对象表示的连接,一个连接对应于它从捕获输入(`AVCaptureInput`的实例)接收的每个媒体流,捕获输出在首次创建时没有任何连接,当向捕获会话添加输出时,将创建连接,将该会话的输入的媒体数据映射到其输出,调用`AVCaptureSession`的`-addOutput:`方法将`AVCaptureOutput`与`AVCaptureSession`关联。 |

||||||

|

`AVCaptureOutput` 是个抽象类,我们必须使用它的子类,常用的 `AVCaptureOutput`的子类如下所示: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

`AVCaptureAudioDataOutput`:一种捕获输出,用于记录音频,并在录制音频时提供对音频样本缓冲区的访问; |

||||||

|

`AVCaptureAudioPreviewOutput` :一种捕获输出,与一个核心音频输出设备相关联、可用于播放由捕获会话捕获的音频; |

||||||

|

`AVCaptureDepthDataOutput` :在兼容的摄像机设备上记录场景深度信息的捕获输出; |

||||||

|

`AVCaptureMetadataOutput` :用于处理捕获会话 `AVCaptureSession` 产生的定时元数据的捕获输出; |

||||||

|

`AVCaptureStillImageOutput`:在macOS中捕捉静止照片的捕获输出。该类在 iOS 10.0 中被弃用,并且不支持新的相机捕获功能,例如原始图像输出和实时照片,在 iOS 10.0 或更高版本中,使用 `AVCapturePhotoOutput` 类代替; |

||||||

|

`AVCapturePhotoOutput` :静态照片、动态照片和其他摄影工作流的捕获输出; |

||||||

|

`AVCaptureVideoDataOutput` :记录视频并提供对视频帧进行处理的捕获输出; |

||||||

|

`AVCaptureFileOutput`:用于捕获输出的抽象超类,可将捕获数据记录到文件中; |

||||||

|

`AVCaptureMovieFileOutput` :继承自 `AVCaptureFileOutput`,将视频和音频记录到 QuickTime 电影文件的捕获输出; |

||||||

|

`AVCaptureAudioFileOutput` :继承自 `AVCaptureFileOutput`,记录音频并将录制的音频保存到文件的捕获输出。 |

||||||

|

|

||||||

|

## 4. AVCaptureSession: |

||||||

|

|

||||||

|

用来管理采集数据和输出数据,它负责协调从哪里采集数据,输出到哪里,它是整个Capture的核心,类似于RunLoop,它不断的从输入源获取数据,然后分发给各个输出源 |

||||||

|

AVCaptureSession 继承自`NSObject`,是`AVFoundation`的核心类,用于管理捕获对象`AVCaptureInput`的视频和音频的输入,协调捕获的输出`AVCaptureOutput` |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 5. AVCaptureConnection: |

||||||

|

|

||||||

|

用于 `AVCaptureSession` 来建立和维护 `AVCaptureInput` 和 `AVCaptureOutput` 之间的连接 |

||||||

|

AVCaptureConnection 是 `Session` 和 `Output` 中间的控制节点,每个 `Output` 与 `Session` 建立连接后,都会分配一个默认的 `AVCpatureConnection`。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 6. AVCapturePreviewLayer: |

||||||

|

|

||||||

|

预览层,`AVCaptureSession` 的一个属性,继承自 `CALayer`,提供摄像头的预览功能,照片以及视频就是通过把 `AVCapturePreviewLayer` 添加到 `UIView` 的 `layer` 上来显示 |

||||||

|

|

||||||

|

开始视频采集 |

||||||

|

1、创建并初始化输入`AVCaptureInput`: `AVCaptureDeviceInput` 和输出`AVCaptureOutput`: `AVCaptureVideoDataOutput`; |

||||||

|

2、创建并初始化 `AVCaptureSession`,把 `AVCaptureInput` 和 `AVCaptureOutput` 添加到 `AVCaptureSession` 中; |

||||||

|

3、调用 `AVCaptureSession` 的 `startRunning` 开启采集 |

||||||

|

初始化输入 |

||||||

|

通过 `AVCaptureDevice` 的 `devicesWithMediaType:` 方法获取摄像头,iPhone 都是有前后摄像头的,这里获取到的是一个设备的数组,要从数组里面拿到我们想要的前摄像头或后摄像头,然后将 `AVCaptureDevice` 转化为 `AVCaptureDeviceInput`,添加到 `AVCaptureSession`中 |

||||||

|

|

||||||

|

```text |

||||||

|

/************************** 设置输入设备 *************************/ |

||||||

|

// --- 获取所有摄像头 --- |

||||||

|

NSArray *cameras = [AVCaptureDevice devicesWithMediaType:AVMediaTypeVideo]; |

||||||

|

// --- 获取当前方向摄像头 --- |

||||||

|

NSArray *captureDeviceArray = [cameras filteredArrayUsingPredicate:[NSPredicate predicateWithFormat:@"position == %d", _capturerParam.devicePosition]]; |

||||||

|

|

||||||

|

if (captureDeviceArray.count == 0) { |

||||||

|

return nil; |

||||||

|

} |

||||||

|

|

||||||

|

// --- 转化为输入设备 --- |

||||||

|

AVCaptureDevice *camera = captureDeviceArray.firstObject; |

||||||

|

self.captureDeviceInput = [AVCaptureDeviceInput deviceInputWithDevice:camera |

||||||

|

error:&error]; |

||||||

|

|

||||||

|

``` |

||||||

|

|

||||||

|

设置视频采集参数 |

||||||

|

|

||||||

|

```text |

||||||

|

@implementation VideoCapturerParam |

||||||

|

|

||||||

|

- (instancetype)init { |

||||||

|

self = [super init]; |

||||||

|

if (self) { |

||||||

|

_devicePosition = AVCaptureDevicePositionFront; // 摄像头位置,默认为前置摄像头 |

||||||

|

_sessionPreset = AVCaptureSessionPreset1280x720; // 视频分辨率 默认 AVCaptureSessionPreset1280x720 |

||||||

|

_frameRate = 15; // 帧 单位为 帧/秒,默认为15帧/秒 |

||||||

|

_videoOrientation = AVCaptureVideoOrientationPortrait; // 摄像头方向 默认为当前手机屏幕方向 |

||||||

|

|

||||||

|

switch ([UIDevice currentDevice].orientation) { |

||||||

|

case UIDeviceOrientationPortrait: |

||||||

|

case UIDeviceOrientationPortraitUpsideDown: |

||||||

|

_videoOrientation = AVCaptureVideoOrientationPortrait; |

||||||

|

break; |

||||||

|

|

||||||

|

case UIDeviceOrientationLandscapeRight: |

||||||

|

_videoOrientation = AVCaptureVideoOrientationLandscapeRight; |

||||||

|

break; |

||||||

|

|

||||||

|

case UIDeviceOrientationLandscapeLeft: |

||||||

|

_videoOrientation = AVCaptureVideoOrientationLandscapeLeft; |

||||||

|

break; |

||||||

|

|

||||||

|

default: |

||||||

|

break; |

||||||

|

} |

||||||

|

} |

||||||

|

|

||||||

|

return self; |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

初始化输出 |

||||||

|

初始化视频输出 `AVCaptureVideoDataOutput`,并设置视频数据格式,设置采集数据回调线程,这里视频输出格式选的是 kCVPixelFormatType_420YpCbCr8BiPlanarFullRange,YUV 数据格式 |

||||||

|

|

||||||

|

```text |

||||||

|

/************************** 设置输出设备 *************************/ |

||||||

|

// --- 设置视频输出 --- |

||||||

|

self.captureVideoDataOutput = [[AVCaptureVideoDataOutput alloc] init]; |

||||||

|

|

||||||

|

NSDictionary *videoSetting = [NSDictionary dictionaryWithObjectsAndKeys:[NSNumber numberWithInt:kCVPixelFormatType_420YpCbCr8BiPlanarVideoRange], kCVPixelBufferPixelFormatTypeKey, nil]; // kCVPixelFormatType_420YpCbCr8BiPlanarVideoRange 表示输出的视频格式为NV12 |

||||||

|

[self.captureVideoDataOutput setVideoSettings:videoSetting]; |

||||||

|

|

||||||

|

// --- 设置输出串行队列和数据回调 --- |

||||||

|

dispatch_queue_t outputQueue = dispatch_queue_create("VideoCaptureOutputQueue", DISPATCH_QUEUE_SERIAL); |

||||||

|

// --- 设置代理 --- |

||||||

|

[self.captureVideoDataOutput setSampleBufferDelegate:self queue:outputQueue]; |

||||||

|

// --- 丢弃延迟的帧 --- |

||||||

|

self.captureVideoDataOutput.alwaysDiscardsLateVideoFrames = YES; |

||||||

|

``` |

||||||

|

|

||||||

|

**初始化 AVCaptureSession 并设置输入输出** |

||||||

|

1、初始化 `AVCaptureSession`,把上面的输入和输出加进来,在添加输入和输出到 `AVCaptureSession` 先查询一下 `AVCaptureSession` 是否支持添加该输入或输出端口; |

||||||

|

2、设置视频分辨率及图像质量(AVCaptureSessionPreset),设置之前同样需要先查询一下 `AVCaptureSession` 是否支持这个分辨率; |

||||||

|

3、如果在已经开启采集的情况下需要修改分辨率或输入输出,需要用 `beginConfiguration` 和`commitConfiguration` 把修改的代码包围起来。在调用 `beginConfiguration` 后,可以配置分辨率、输入输出等,直到调用 `commitConfiguration` 了才会被应用; |

||||||

|

4、`AVCaptureSession` 管理了采集过程中的状态,当开始采集、停止采集、出现错误等都会发起通知,我们可以监听通知来获取 `AVCaptureSession` 的状态,也可以调用其属性来获取当前 `AVCaptureSession` 的状态, `AVCaptureSession` 相关的通知都是在主线程的。 |

||||||

|

|

||||||

|

前置摄像头采集到的画面是翻转的,若要解决画面翻转问题,需要设置 `AVCaptureConnection` 的 `videoMirrored` 为 YES。 |

||||||

|

|

||||||

|

```text |

||||||

|

/************************** 初始化会话 *************************/ |

||||||

|

self.captureSession = [[AVCaptureSession alloc] init]; |

||||||

|

self.captureSession.usesApplicationAudioSession = NO; |

||||||

|

|

||||||

|

// --- 添加输入设备到会话 --- |

||||||

|

if ([self.captureSession canAddInput:self.captureDeviceInput]) { |

||||||

|

[self.captureSession addInput:self.captureDeviceInput]; |

||||||

|

} |

||||||

|

else { |

||||||

|

NSLog(@"VideoCapture:: Add captureVideoDataInput Faild!"); |

||||||

|

return nil; |

||||||

|

} |

||||||

|

|

||||||

|

// --- 添加输出设备到会话 --- |

||||||

|

if ([self.captureSession canAddOutput:self.captureVideoDataOutput]) { |

||||||

|

[self.captureSession addOutput:self.captureVideoDataOutput]; |

||||||

|

} |

||||||

|

else { |

||||||

|

NSLog(@"VideoCapture:: Add captureVideoDataOutput Faild!"); |

||||||

|

return nil; |

||||||

|

} |

||||||

|

|

||||||

|

// --- 设置分辨率 --- |

||||||

|

if ([self.captureSession canSetSessionPreset:self.capturerParam.sessionPreset]) { |

||||||

|

self.captureSession.sessionPreset = self.capturerParam.sessionPreset; |

||||||

|

} |

||||||

|

|

||||||

|

/************************** 初始化连接 *************************/ |

||||||

|

self.captureConnection = [self.captureVideoDataOutput connectionWithMediaType:AVMediaTypeVideo]; |

||||||

|

|

||||||

|

// --- 设置摄像头镜像,不设置的话前置摄像头采集出来的图像是反转的 --- |

||||||

|

if (self.capturerParam.devicePosition == AVCaptureDevicePositionFront && self.captureConnection.supportsVideoMirroring) { // supportsVideoMirroring 视频是否支持镜像 |

||||||

|

self.captureConnection.videoMirrored = YES; |

||||||

|

} |

||||||

|

|

||||||

|

self.captureConnection.videoOrientation = self.capturerParam.videoOrientation; |

||||||

|

|

||||||

|

self.videoPreviewLayer = [AVCaptureVideoPreviewLayer layerWithSession:self.captureSession]; |

||||||

|

self.videoPreviewLayer.connection.videoOrientation = self.capturerParam.videoOrientation; |

||||||

|

self.videoPreviewLayer.videoGravity = AVLayerVideoGravityResizeAspectFill; |

||||||

|

``` |

||||||

|

|

||||||

|

采集视频 / 回调 |

||||||

|

|

||||||

|

```text |

||||||

|

/** |

||||||

|

* 开始采集 |

||||||

|

*/ |

||||||

|

- (NSError *)startCpture { |

||||||

|

if (self.isCapturing) { |

||||||

|

return [NSError errorWithDomain:@"VideoCapture:: startCapture faild: is capturing" code:1 userInfo:nil]; |

||||||

|

} |

||||||

|

|

||||||

|

// --- 摄像头权限判断 --- |

||||||

|

AVAuthorizationStatus videoAuthStatus = [AVCaptureDevice authorizationStatusForMediaType:AVMediaTypeVideo]; |

||||||

|

|

||||||

|

if (videoAuthStatus != AVAuthorizationStatusAuthorized) { |

||||||

|

return [NSError errorWithDomain:@"VideoCapture:: Camera Authorizate faild!" code:1 userInfo:nil]; |

||||||

|

} |

||||||

|

|

||||||

|

[self.captureSession startRunning]; |

||||||

|

self.isCapturing = YES; |

||||||

|

|

||||||

|

kLOGt(@"开始采集视频"); |

||||||

|

|

||||||

|

return nil; |

||||||

|

} |

||||||

|

|

||||||

|

|

||||||

|

/** |

||||||

|

* 停止采集 |

||||||

|

*/ |

||||||

|

- (NSError *)stopCapture { |

||||||

|

if (!self.isCapturing) { |

||||||

|

return [NSError errorWithDomain:@"VideoCapture:: stop capture faild! is not capturing!" code:1 userInfo:nil]; |

||||||

|

} |

||||||

|

|

||||||

|

[self.captureSession stopRunning]; |

||||||

|

self.isCapturing = NO; |

||||||

|

|

||||||

|

kLOGt(@"停止采集视频"); |

||||||

|

|

||||||

|

return nil; |

||||||

|

} |

||||||

|

|

||||||

|

#pragma mark ————— AVCaptureVideoDataOutputSampleBufferDelegate ————— |

||||||

|

/** |

||||||

|

* 摄像头采集数据回调 |

||||||

|

@prama output 输出设备 |

||||||

|

@prama sampleBuffer 帧缓存数据,描述当前帧信息 |

||||||

|

@prama connection 连接 |

||||||

|

*/ |

||||||

|

- (void)captureOutput:(AVCaptureOutput *)output didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection { |

||||||

|

if ([self.delagate respondsToSelector:@selector(videoCaptureOutputDataCallback:)]) { |

||||||

|

[self.delagate videoCaptureOutputDataCallback:sampleBuffer]; |

||||||

|

} |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

## 7.调用 / 获取数据 |

||||||

|

|

||||||

|

调用很简单,初始化视频采集参数 `VideoCapturerParam` 和 视频采集器 `VideoVapturer` , 设置预览图层 `videoPreviewLayer` , 调用 `startCpture` 就可以开始采集了,然后实现数据采集回调的代理方法 `videoCaptureOutputDataCallback` 获取数据 |

||||||

|

|

||||||

|

```text |

||||||

|

// --- 初始化视频采集参数 --- |

||||||

|

VideoCapturerParam *param = [[VideoCapturerParam alloc] init]; |

||||||

|

|

||||||

|

// --- 初始化视频采集器 --- |

||||||

|

self.videoCapture = [[VideoVapturer alloc] initWithCaptureParam:param error:nil]; |

||||||

|

self.videoCapture.delagate = self; |

||||||

|

|

||||||

|

// --- 开始采集 --- |

||||||

|

[self.videoCapture startCpture]; |

||||||

|

|

||||||

|

|

||||||

|

// --- 初始化预览View --- |

||||||

|

self.recordLayer = self.videoCapture.videoPreviewLayer; |

||||||

|

self.recordLayer.frame = CGRectMake(0, 0, CGRectGetWidth(self.view.bounds), CGRectGetHeight(self.view.bounds)); |

||||||

|

[self.view.layer addSublayer:self.recordLayer]; |

||||||

|

``` |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

```text |

||||||

|

#pragma mark ————— VideoCapturerDelegate ————— 视频采集回调 |

||||||

|

- (void)videoCaptureOutputDataCallback:(CMSampleBufferRef)sampleBuffer { |

||||||

|

NSLog(@"%@ sampleBuffer : %@ ", kLOGt(@"视频采集回调"), sampleBuffer); |

||||||

|

} |

||||||

|

``` |

||||||

|

|

||||||

|

至此,我们就完成了视频的采集,在采集前和过程中,我们可能会对采集参数、摄像头方向、帧率等进行修改。 |

||||||

|

|

||||||

|

原文https://zhuanlan.zhihu.com/p/485646912 |

||||||

@ -0,0 +1,228 @@ |

|||||||

|

# iOS高级视频渲染 |

||||||

|

|

||||||

|

## 1.前言 |

||||||

|

|

||||||

|

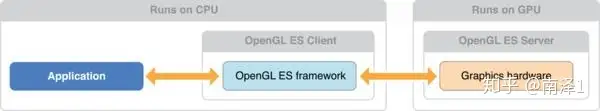

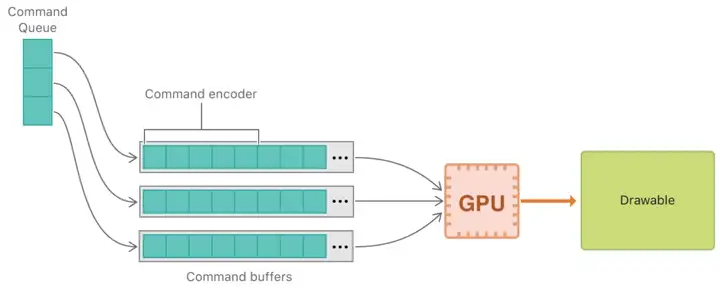

今天为大家介绍一下 iOS 下 WebRTC是如何渲染视频的。在iOS中有两种加速渲染视频的方法。一种是使用OpenGL;另一种是使用 Metal。 |

||||||

|

|

||||||

|

OpenGL的好处是跨平台,推出时间比较长,因此比较稳定。兼容性也比较好。而Metal是iOS最近才推出的技术,理论上来说比OpenGL ES效率更高。 |

||||||

|

|

||||||

|

WebRTC中这两种渲染方式都支持。它首先会判断当前iOS系统是否支持Metal,如果支持的话,优先使用Metal。如果不支持的话,就使用 OpenGL ES。 |

||||||

|

|

||||||

|

我们今天介绍的是 OpenGL ES的方案。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### 1.1创建 OpenGL 上下文 |

||||||

|

|

||||||

|

在iOS中使用OpenGL ES做视频渲染时,首先要创建EAGLContext对象。这是因为,EAGLContext管理着 OpengGL ES 渲染上下文。该上下文中,包括了状态信息,渲染命令以及OpenGL ES绘制资源(如纹理和renderbuffers)。为了执行OpenGL ES命令,你需要将创建的EAGLContext设置为当前渲染上下文。 |

||||||

|

|

||||||

|

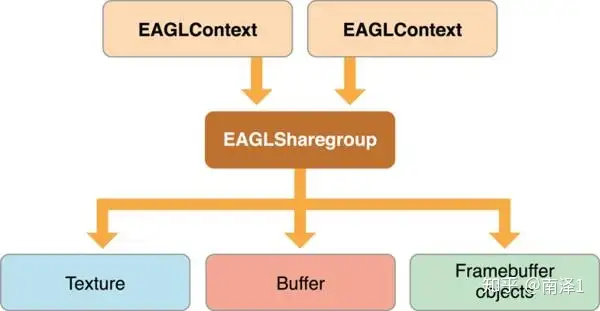

EAGLContext并不直接管理绘制资源,它通过与上下文相关的EAGLSharegroup对象来管理。当创建EAGLContext时,你可以选择创建一个新的sharegroup或与之前创建的EAGLContext共享EAGLSharegroup。 |

||||||

|

|

||||||

|

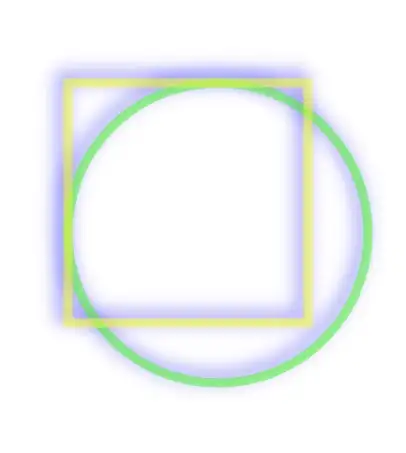

EAGLContext与EAGLSharegroup的关系如下图所示: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

WebRTC中并没有使用共享EAGLSharegroup的情况,所以对于这种情况我们这里就不做特别讲解了。有兴趣的同学可以在网上查找相关资料。 |

||||||

|

|

||||||

|

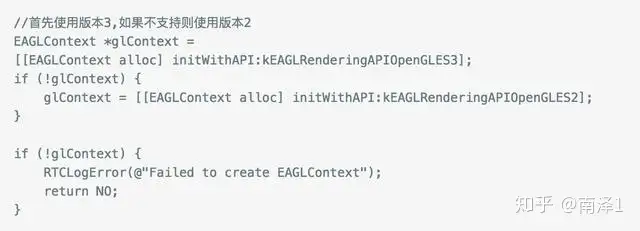

目前,OpenGL ES有3个版本,主要使用版本2和版本3 。所以我们在创建时要对其作判断。首先看是否支持版本3,如果不支持我们就使用版本2。 |

||||||

|

|

||||||

|

代码如下: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

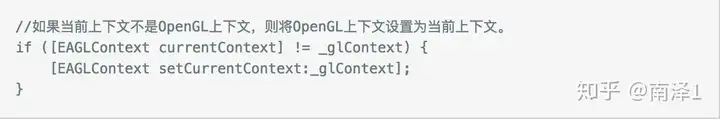

创建完上下文后,我们还要将它设置为当前上下文,这样它才能真正起作用。 |

||||||

|

|

||||||

|

代码如下: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

> 需要注意的是,由于应用切换到后台后,上下文就发生了切换。所以当它切换到前台时,也要做上面那个判断。 |

||||||

|

|

||||||

|

OpenGL ES上下文创建好后,下面我们看一下如何创建View。 |

||||||

|

|

||||||

|

### 1.2创建 OpenGL View |

||||||

|

|

||||||

|

在iOS中,有两种展示层,一种是 GLKView,另一种是 CAEAGLLayer。WebRTC中使用GLKView进行展示。CAEAGLLayer暂不做介绍。 |

||||||

|

|

||||||

|

GLKit框架提供了View和View Controller类以减少建立和维护绘制 OpenGL ES 内容的代码。GLKView类用于管理展示部分;GLKViewController类用于管理绘制的内容。它们都是继承自UIKit。GLKView的好处是,开发人员可以将自己的精力聚焦在OpenGL ES渲染的工作上。 |

||||||

|

|

||||||

|

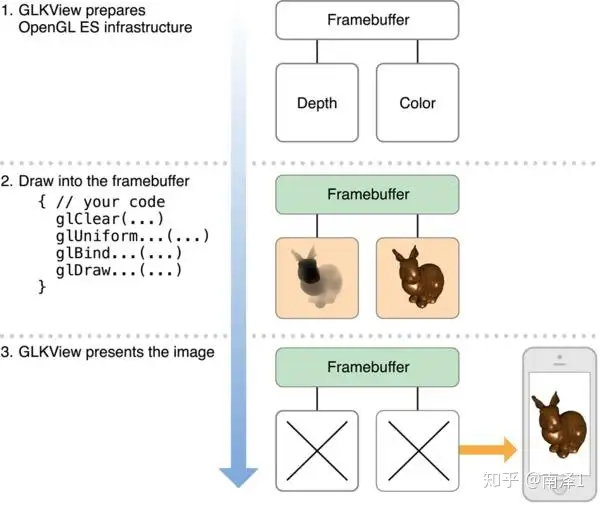

GLKView展示的基本流程如下: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

如上图所示,绘制 OpenGL ES 内容有三步: |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

- 准备 OpenGL ES环境; |

||||||

|

- 发送绘制命令; |

||||||

|

- 展示渲染内容。 |

||||||

|

|

||||||

|

GLKView类自己实现了第一步和第三步。第二步由开发人员来完成,也就是要实现drawRect函数。GLKView之所以能为OpenGL ES 提供简单的绘制接口,是因为它管理了OpenGL ES 渲染过程的标准部分: |

||||||

|

|

||||||

|

在调用绘制方法之前: |

||||||

|

|

||||||

|

使用 EAGLContext 作为当前上下文。 |

||||||

|

|

||||||

|

根据size, 缩放因子和绘制属性,创建 FBO 和 renderbuffer。 |

||||||

|

|

||||||

|

绑定 FBO,作为绘制命令的当前目的地。 |

||||||

|

|

||||||

|

匹配 OpenGL ES viewport与 framebuffer size 。 |

||||||

|

|

||||||

|

在绘制方法返回之后: |

||||||

|

|

||||||

|

解决多采样 buffers(如果开启了多采样)。 |

||||||

|

|

||||||

|

当内容不在需要时,丢掉 renderbuffers。 |

||||||

|

|

||||||

|

展示renderbuffer内容。 |

||||||

|

|

||||||

|

使用GLKView有两种方法,一种是实现一个类,直接继承自GLKView,并实现drawRect方法。另一种是实现GLKView的代理,也就是GLKViewDelegate,并实现drawInRect方法。 |

||||||

|

|

||||||

|

在WebRTC中,使用的是第二种方法。RTCEAGLVideoView 是GLKView的包裹类,并且继承自GLKViewDelegate。 |

||||||

|

|

||||||

|

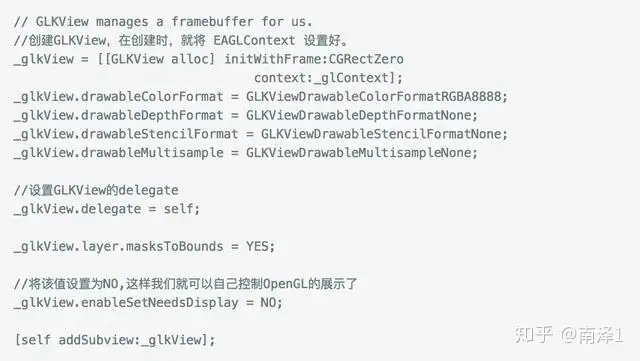

首先,创建GLKView. |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

创建好GLKView后,需要将glkView.delegate设置为RTCEAGLVideoView,这样就可以将绘制工作交由RTCEAGLVideoView来完成了。另外, glkView.enableSetNeedsDisplay 设置为 NO,由我们自己来控制何时进行绘制。 |

||||||

|

|

||||||

|

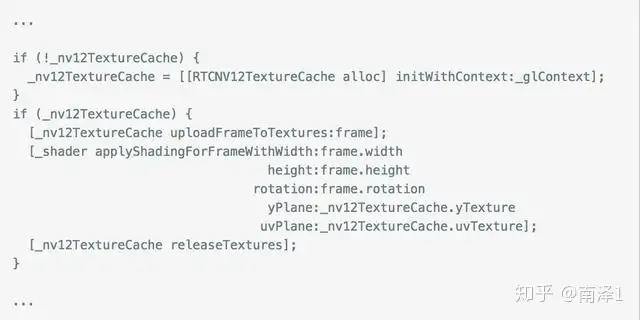

然后,实现drawInRect方法。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

上面的代码就是通过Shader来绘制NV12的YUV数据到View中。这段代码的基本意思是将一个解码后的视频帧分解成Y数据纹理及UV数据纹理。然后调用Shader程序将纹理转成rgb数据,最终渲染到View中。 |

||||||

|

|

||||||

|

## 2.Shader程序 |

||||||

|

|

||||||

|

OpenGL ES 有两种 Shader。一种是顶点(Vetex)Shader; 另一种是片元(fragment )Shader。 |

||||||

|

|

||||||

|

Vetex Shader: 用于绘制顶点。 |

||||||

|

|

||||||

|

Fragment Shader:用于绘制像素点。 |

||||||

|

|

||||||

|

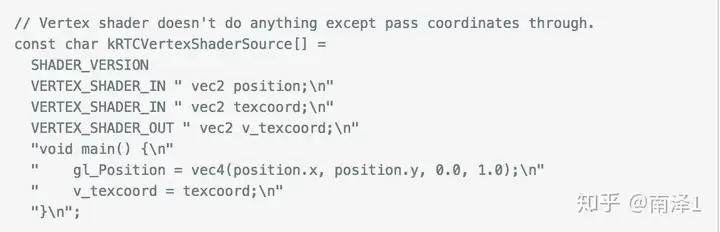

Vetex Shader |

||||||

|

|

||||||

|

Vetex Shader用于绘制图形的顶点。我们都知道,无论是2D还是3D图形,它们都是由顶点构成的。 |

||||||

|

|

||||||

|

在OpenGL ES中,有三种基本图元,分别是点,线,三角形。由它们再构成更复杂的图形。而点、线、三角形又都是由点组成的。 |

||||||

|

|

||||||

|

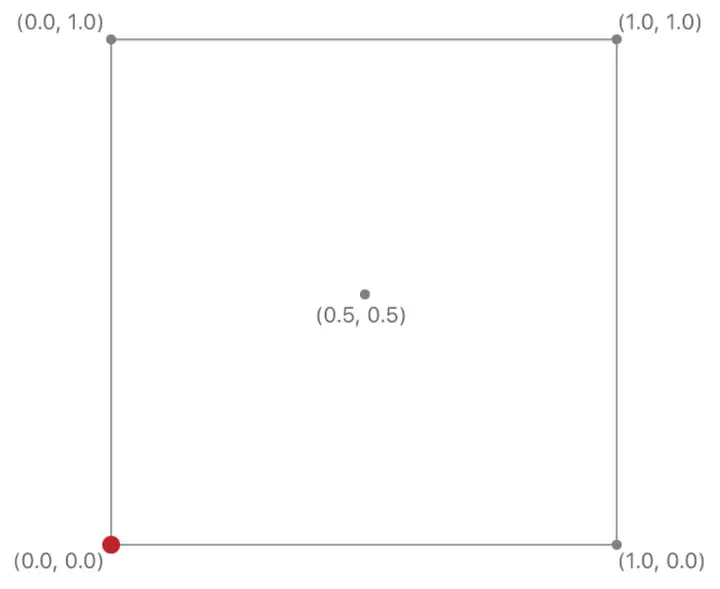

视频是在一个矩形里显示,所以我们要通过基本图元构建一个矩形。理论上,距形可以通过点、线绘制出来,但这样做的话,OpenGL ES就要绘制四次。而通过三角形绘制只需要两次,所以使用三角形执行速度更快。 下面的代码就是 WebRTC 中的Vetex Shader程序。该程序的作用是每个顶点执行一次,将用户输入的顶点输出到 gl_Position中,并将顶点的纹理作标点转作为 Fragment Shader 的输入。 |

||||||

|

|

||||||

|

1.OpenGL坐标原点是屏幕的中心。纹理坐标的原点是左下角。 |

||||||

|

|

||||||

|

2.gl_Position是Shader的内部变量,存放一个项点的坐标。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

OpenGL ES Shader语法请见我的另一篇文章着色器 |

||||||

|

|

||||||

|

### 2.1fragment Shader |

||||||

|

|

||||||

|

fragment Shader程序是对片元着色,每个片元执行一次。片元与像素差不多。可以简单的把片元理解为像素。 |

||||||

|

|

||||||

|

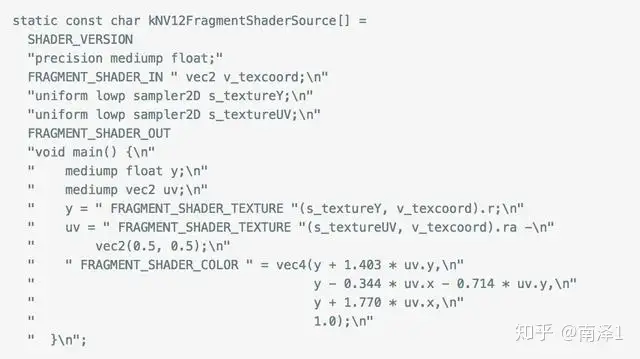

下面的代码是WebRTC中的 fragment |

||||||

|

|

||||||

|

> YUV有多种格式,可以参见我的另一篇文章YUV。 |

||||||

|

|

||||||

|

在代码中,使用FRAGMENT_SHADER_TEXTURE命令,也就是OpenGL ES中的 texture2D 函数,分别从 Y 数据纹理中取出 y值,从 UV 数据纹理中取出 uv值,然后通过公式计算出每个像素(实际是片元)的 rgb值。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

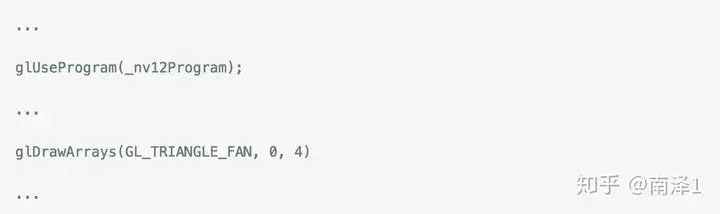

有了顶点数据和片元的RGB值后,就可以调用OpenGL ES的 draw 方法进行视频的绘制了。 |

||||||

|

|

||||||

|

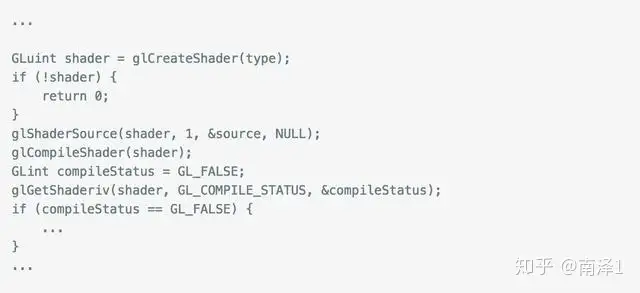

Shader的编译、链接与使用 上面介绍了 WebRTC下 Vetex Shader 和 Fragment Shader程序。要想让程序运行起来,还要额外做一些工作。 |

||||||

|

|

||||||

|

OpenGL ES的 shader程序与C程序差不多。想像一下C程序,要想让一个C程序运行起来,要有以下几个步骤: |

||||||

|

|

||||||

|

- 写好程序代码 |

||||||

|

- 编译 |

||||||

|

- 链接 |

||||||

|

- 执行 |

||||||

|

|

||||||

|

Shader程序的运行也是如此。我们看看 WebRTC是如何做的。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

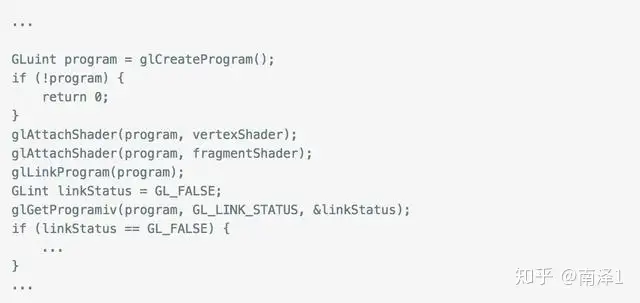

它首先创建一个 Shader, 然后将上面的 Shader 程序与 Shader 绑定。之后编译 Shader。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

编译成功后,创建 program 对象。 将之前创建的 Shader 与program绑定到一起。之后做链接工作。一切准备就绪后,就可以使用Shader程序绘制视频了。 |

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### 2.2WebRTC中视频渲染相关文件 |

||||||

|

|

||||||

|

RTCEAGLVideoView.m/h:创建 EAGLContext及OpenGL ES View,并将视频数据显示出来。 |

||||||

|

|

||||||

|

RTCShader.mm/h:OpenGL ES Shader 程序的创建,编译与链接相关的代码。 |

||||||

|

|

||||||

|

RTCDefaultShader.mm/h: Shader 程序,绘制相关的代码。 |

||||||

|

|

||||||

|

RTCNV12TextureCache.mm/h: 用于生成 YUV NV12 相关纹理的代码。 |

||||||

|

|

||||||

|

RTCI420TexutreCache.mm/h: 用于生成 I420 相关纹理的代码。 |

||||||

|

|

||||||

|

## 3.小结 |

||||||

|

|

||||||

|

本文对 WebRTC 中 OpenGL ES 渲染做了介绍。通过本篇文章大家可以了解到WebRTC是如何将视频渲染出来的。包括: |

||||||

|

|

||||||

|

上下文的创建与初始化。 |

||||||

|

|

||||||

|

GLKView的创建。 |

||||||

|

|

||||||

|

绘制方法的实现。 |

||||||

|

|

||||||

|

Shader代码的分析。 |

||||||

|

|

||||||

|

Shader的编译与执行。 |

||||||

|

|

||||||

|

原文https://zhuanlan.zhihu.com/p/146950864 |

||||||

@ -0,0 +1,246 @@ |

|||||||

|

# 【OpenGL入门】iOS 图像渲染原理 |

||||||

|

|

||||||

|

- CPU(Central Processing Unit):现代计算机的三大核心部分之一,作为整个系统的运算和控制单元。CPU 内部的流水线结构使其拥有一定程度的并行计算能力。 |

||||||

|

- GPU(Graphics Processing Unit):一种可进行绘图运算工作的专用微处理器。GPU 能够生成 2D/3D 的图形图像和视频,从而能够支持基于窗口的操作系统、图形用户界面、视频游戏、可视化图像应用和视频播放。GPU 具有非常强的并行计算能力。 |

||||||

|

|

||||||

|

使用 GPU 渲染图形的根本原因就是速度问题。GPU 优秀的并行计算能力使其能够快速将图形结果计算出来并在屏幕的所有像素中进行显示。 |

||||||

|

|

||||||

|

**屏幕图像的显示原理** |

||||||

|

|

||||||

|

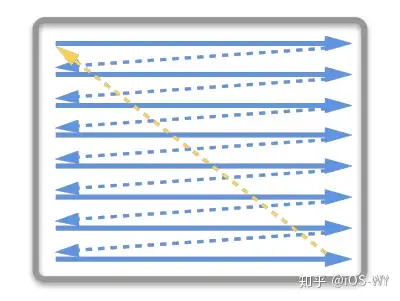

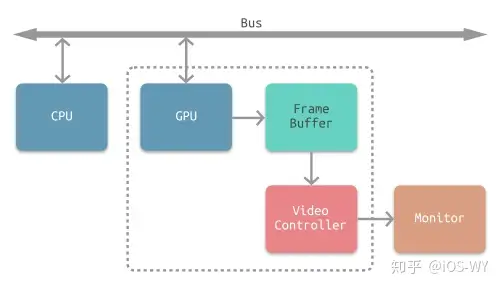

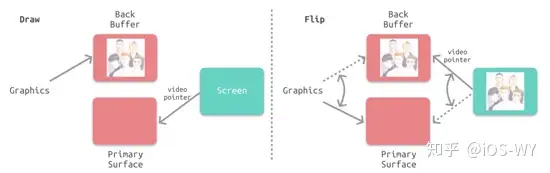

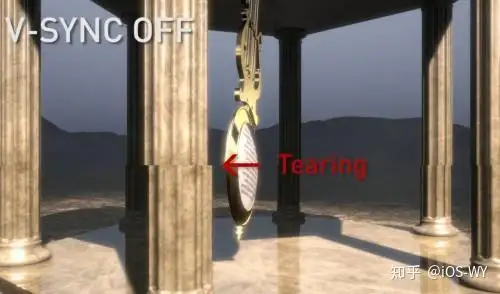

介绍屏幕图像显示的原理,需要先从 CRT 显示器原理说起,如下图所示。CRT 的电子枪从上到下逐行扫描,扫描完成后显示器就呈现一帧画面。然后电子枪回到初始位置进行下一次扫描。为了同步显示器的显示过程和系统的显示控制器,显示器会用硬件时钟产生一系列的定时信号。当电子枪换行进行扫描时,显示器会发出一个水平同步信号(horizonal synchronization),简称 HSync;而当一帧画面绘制完成后,电子枪回复到原位,准备画下一帧前,显示器会发出一个垂直同步信号(vertical synchronization),简称 VSync。显示器通常以固定频率进行刷新,这个刷新率就是 VSync 信号产生的频率。虽然现在的显示器基本都是液晶显示屏了,但其原理基本一致。 |

||||||

|

|

||||||

|

|

||||||

|

|